Difference between revisions of "नाँलेज ग्राफ एम्बेडिंग"

| Line 1: | Line 1: | ||

{{Short description|Dimensionality reduction of graph-based semantic data objects [machine learning task]}} | {{Short description|Dimensionality reduction of graph-based semantic data objects [machine learning task]}} | ||

[[File:KnowledgeGraphEmbedding.png|thumb|ज्ञान ग्राफ का एम्बेडिंग. एम्बेडिंग और संबंधों के सदिश प्रतिनिधित्व का उपयोग विभिन्न मशीन सीखने के अनुप्रयोगों के लिए किया जा सकता है।]]प्रतिनिधित्व शिक्षण में, '''ज्ञान ग्राफ एम्बेडिंग''' '''(KGE)''', जिसे ज्ञान प्रतिनिधित्व शिक्षण (KRL), या बहु-संबंध शिक्षण भी कहा जाता है,<ref name=":0">{{Cite journal|last1=Ji|first1=Shaoxiong|last2=Pan|first2=Shirui|last3=Cambria|first3=Erik|last4=Marttinen|first4=Pekka|last5=Yu|first5=Philip S.|date=2021|title=A Survey on Knowledge Graphs: Representation, Acquisition, and Applications|url=https://ieeexplore.ieee.org/document/9416312|journal=IEEE Transactions on Neural Networks and Learning Systems|volume=PP|issue=2 |pages=494–514|doi=10.1109/TNNLS.2021.3070843|pmid=33900922|arxiv=2002.00388|hdl=10072/416709 |s2cid=211010433|issn=2162-237X}}</ref> [[ज्ञान ग्राफ]] की एम्बेडिंग और संबंधों के अर्थपूर्ण अर्थ को संरक्षित करते हुए उनके निम्न-आयामी प्रतिनिधित्व को सीखने का एक मशीन सीखने का | [[File:KnowledgeGraphEmbedding.png|thumb|ज्ञान ग्राफ का एम्बेडिंग. एम्बेडिंग और संबंधों के सदिश प्रतिनिधित्व का उपयोग विभिन्न मशीन सीखने के अनुप्रयोगों के लिए किया जा सकता है।]]प्रतिनिधित्व शिक्षण में, '''ज्ञान ग्राफ एम्बेडिंग''' '''(KGE)''', जिसे ज्ञान प्रतिनिधित्व शिक्षण (KRL), या बहु-संबंध शिक्षण भी कहा जाता है,<ref name=":0">{{Cite journal|last1=Ji|first1=Shaoxiong|last2=Pan|first2=Shirui|last3=Cambria|first3=Erik|last4=Marttinen|first4=Pekka|last5=Yu|first5=Philip S.|date=2021|title=A Survey on Knowledge Graphs: Representation, Acquisition, and Applications|url=https://ieeexplore.ieee.org/document/9416312|journal=IEEE Transactions on Neural Networks and Learning Systems|volume=PP|issue=2 |pages=494–514|doi=10.1109/TNNLS.2021.3070843|pmid=33900922|arxiv=2002.00388|hdl=10072/416709 |s2cid=211010433|issn=2162-237X}}</ref> [[ज्ञान ग्राफ]] की एम्बेडिंग और संबंधों के अर्थपूर्ण अर्थ को संरक्षित करते हुए उनके निम्न-आयामी प्रतिनिधित्व को सीखने का एक मशीन सीखने का क्रिया है।<ref name=":0" /><ref>{{Cite journal|last1=Mohamed|first1=Sameh K|last2=Nováček|first2=Vít|last3=Nounu|first3=Aayah|date=2019-08-01|editor-last=Cowen|editor-first=Lenore|title=नॉलेज ग्राफ एंबेडिंग का उपयोग करके प्रोटीन औषधि लक्ष्य की खोज करना|url=https://academic.oup.com/bioinformatics/advance-article/doi/10.1093/bioinformatics/btz600/5542390|journal=Bioinformatics|volume=36|issue=2|language=en|pages=603–610|doi=10.1093/bioinformatics/btz600|pmid=31368482|issn=1367-4803|hdl=10379/15375|hdl-access=free}}</ref><ref name=":2">{{cite arXiv|last1=Lin|first1=Yankai|last2=Han|first2=Xu|last3=Xie|first3=Ruobing|last4=Liu|first4=Zhiyuan|last5=Sun|first5=Maosong|date=2018-12-28|title=Knowledge Representation Learning: A Quantitative Review|class=cs.CL|eprint=1812.10901}}</ref> उनके [[एम्बेडिंग]] प्रतिनिधित्व का लाभ उठाते हुए, ज्ञान ग्राफ़ (केजी) का उपयोग [[लिंक भविष्यवाणी]], ट्रिपल वर्गीकरण, [[इकाई मान्यता]], [[क्लस्टर विश्लेषण]] और [[संबंध निष्कर्षण]] जैसे विभिन्न अनुप्रयोगों के लिए किया जा सकता है।<ref name=":0" /><ref name=":32">{{Cite journal|last1=Abu-Salih|first1=Bilal|last2=Al-Tawil|first2=Marwan|last3=Aljarah|first3=Ibrahim|last4=Faris|first4=Hossam|last5=Wongthongtham|first5=Pornpit|last6=Chan|first6=Kit Yan|last7=Beheshti|first7=Amin|date=2021-05-12|title=नॉलेज ग्राफ एंबेडिंग का उपयोग करके सामाजिक राजनीति का संबंधपरक शिक्षण विश्लेषण|url=https://doi.org/10.1007/s10618-021-00760-w|journal=Data Mining and Knowledge Discovery|volume=35|issue=4|pages=1497–1536|language=en|doi=10.1007/s10618-021-00760-w|arxiv=2006.01626|s2cid=219179556|issn=1573-756X}}</ref> | ||

== परिभाषा == | == परिभाषा == | ||

एक ज्ञान ग्राफ <math>\mathcal{G} = \{E, R, F\}</math> इकाई <math>E | एक ज्ञान ग्राफ <math>\mathcal{G} = \{E, R, F\}</math> इकाई <math>E | ||

</math>, संबंध <math>R</math>, और तथ्य <math>F</math> का एक संग्रह है।<ref name=":1">{{Cite journal|last1=Rossi|first1=Andrea|last2=Barbosa|first2=Denilson|last3=Firmani|first3=Donatella|last4=Matinata|first4=Antonio|last5=Merialdo|first5=Paolo|date=2020|title=Knowledge Graph Embedding for Link Prediction: A Comparative Analysis|url=https://dl.acm.org/doi/10.1145/3424672|journal=ACM Transactions on Knowledge Discovery from Data|language=en|volume=15|issue=2|pages=1–49|doi=10.1145/3424672|arxiv=2002.00819|hdl=11573/1638610 |s2cid=211011226|issn=1556-4681}}</ref> एक तथ्य एक ट्रिपल <math>(h, r, t) \in F</math> है जो ट्रिपल के हेड <math>h \in E</math> और टेल <math>t \in E</math> के बीच एक लिंक <math>r \in R</math> को दर्शाता है। एक अन्य संकेतन जो प्रायः साहित्य में ट्रिपल (या तथ्य) का प्रतिनिधित्व करने के लिए उपयोग किया जाता है वह है <math><head, relation, tail></math>। इस नोटेशन को संसाधन विवरण स्ट्रक्चर (आरडीएफ) कहा जाता है।<ref name=":0" /><ref name=":1" /> एक ज्ञान ग्राफ़ विशिष्ट डोमेन से संबंधित ज्ञान का प्रतिनिधित्व करता है; इस संरचित प्रतिनिधित्व का लाभ उठाते हुए, कुछ शोधन चरणों के बाद इससे नवीन ज्ञान का अनुमान लगाना संभव है।<ref name=":27">{{Cite journal|last=Paulheim|first=Heiko|date=2016-12-06|editor-last=Cimiano|editor-first=Philipp|title=Knowledge graph refinement: A survey of approaches and evaluation methods|url=https://www.medra.org/servlet/aliasResolver?alias=iospress&doi=10.3233/SW-160218|journal=Semantic Web|volume=8|issue=3|pages=489–508|doi=10.3233/SW-160218|s2cid=13151033 }}</ref> यद्यपि, आजकल, लोगों को वास्तविक संसार के एप्लिकेशन में उनका उपयोग करने के लिए डेटा की विरलता और कम्प्यूटेशनल अक्षमता से निपटना पड़ता है।<ref name=":2" /><ref name=":3">{{Cite journal|last1=Dai|first1=Yuanfei|last2=Wang|first2=Shiping|last3=Xiong|first3=Neal N.|last4=Guo|first4=Wenzhong|date=May 2020|title=A Survey on Knowledge Graph Embedding: Approaches, Applications and Benchmarks|journal=Electronics|language=en|volume=9|issue=5|pages=750|doi=10.3390/electronics9050750|doi-access=free}}</ref> | </math>, संबंध <math>R</math>, और तथ्य <math>F</math> का एक संग्रह है।<ref name=":1">{{Cite journal|last1=Rossi|first1=Andrea|last2=Barbosa|first2=Denilson|last3=Firmani|first3=Donatella|last4=Matinata|first4=Antonio|last5=Merialdo|first5=Paolo|date=2020|title=Knowledge Graph Embedding for Link Prediction: A Comparative Analysis|url=https://dl.acm.org/doi/10.1145/3424672|journal=ACM Transactions on Knowledge Discovery from Data|language=en|volume=15|issue=2|pages=1–49|doi=10.1145/3424672|arxiv=2002.00819|hdl=11573/1638610 |s2cid=211011226|issn=1556-4681}}</ref> एक तथ्य एक ट्रिपल <math>(h, r, t) \in F</math> है जो ट्रिपल के हेड <math>h \in E</math> और टेल <math>t \in E</math> के बीच एक लिंक <math>r \in R</math> को दर्शाता है। एक अन्य संकेतन जो प्रायः साहित्य में ट्रिपल (या तथ्य) का प्रतिनिधित्व करने के लिए उपयोग किया जाता है वह है <math><head, relation, tail></math>। इस नोटेशन को संसाधन विवरण स्ट्रक्चर (आरडीएफ) कहा जाता है।<ref name=":0" /><ref name=":1" /> एक ज्ञान ग्राफ़ विशिष्ट डोमेन से संबंधित ज्ञान का प्रतिनिधित्व करता है; इस संरचित प्रतिनिधित्व का लाभ उठाते हुए, कुछ शोधन चरणों के बाद इससे नवीन ज्ञान का अनुमान लगाना संभव है।<ref name=":27">{{Cite journal|last=Paulheim|first=Heiko|date=2016-12-06|editor-last=Cimiano|editor-first=Philipp|title=Knowledge graph refinement: A survey of approaches and evaluation methods|url=https://www.medra.org/servlet/aliasResolver?alias=iospress&doi=10.3233/SW-160218|journal=Semantic Web|volume=8|issue=3|pages=489–508|doi=10.3233/SW-160218|s2cid=13151033 }}</ref> यद्यपि, आजकल, लोगों को वास्तविक संसार के एप्लिकेशन में उनका उपयोग करने के लिए डेटा की विरलता और कम्प्यूटेशनल अक्षमता से निपटना पड़ता है।<ref name=":2" /><ref name=":3">{{Cite journal|last1=Dai|first1=Yuanfei|last2=Wang|first2=Shiping|last3=Xiong|first3=Neal N.|last4=Guo|first4=Wenzhong|date=May 2020|title=A Survey on Knowledge Graph Embedding: Approaches, Applications and Benchmarks|journal=Electronics|language=en|volume=9|issue=5|pages=750|doi=10.3390/electronics9050750|doi-access=free}}</ref> | ||

ज्ञान ग्राफ का एम्बेडिंग प्रत्येक इकाई और ज्ञान ग्राफ के संबंध, <math>\mathcal{G}</math> को किसी दिए गए आयाम <math>d</math>, के सदिश में अनुवादित करता है, जिसे एम्बेडिंग आयाम कहा जाता है।<ref name=":3" /> सामान्य स्थिति में, हमारे निकट इकाई <math>d</math> और संबंध <math>k</math> के लिए अलग-अलग एम्बेडिंग आयाम हो सकते हैं।<ref name=":3" /> ज्ञान ग्राफ में सभी एम्बेडिंग और संबंधों के लिए एम्बेडिंग सदिश का संग्रह तब डाउनस्ट्रीम | ज्ञान ग्राफ का एम्बेडिंग प्रत्येक इकाई और ज्ञान ग्राफ के संबंध, <math>\mathcal{G}</math> को किसी दिए गए आयाम <math>d</math>, के सदिश में अनुवादित करता है, जिसे एम्बेडिंग आयाम कहा जाता है।<ref name=":3" /> सामान्य स्थिति में, हमारे निकट इकाई <math>d</math> और संबंध <math>k</math> के लिए अलग-अलग एम्बेडिंग आयाम हो सकते हैं।<ref name=":3" /> ज्ञान ग्राफ में सभी एम्बेडिंग और संबंधों के लिए एम्बेडिंग सदिश का संग्रह तब डाउनस्ट्रीम क्रियाओं के लिए उपयोग किया जा सकता है। | ||

एक ज्ञान ग्राफ़ एम्बेडिंग को चार अलग-अलग गुणों की विशेषता है:<ref name=":0" /> | एक ज्ञान ग्राफ़ एम्बेडिंग को चार अलग-अलग गुणों की विशेषता है:<ref name=":0" /> | ||

| Line 39: | Line 39: | ||

इन सूचकांकों का उपयोग प्रायः किसी मॉडल की एम्बेडिंग गुणवत्ता को मापने के लिए किया जाता है। सूचकांकों की सरलता उन्हें बड़े पैमाने पर भी एम्बेडिंग एल्गोरिदम के प्रदर्शन का मूल्यांकन करने के लिए बहुत उपयुक्त बनाती है।<ref name=":31">{{Cite journal|last1=Chen|first1=Zhe|last2=Wang|first2=Yuehan|last3=Zhao|first3=Bin|last4=Cheng|first4=Jing|last5=Zhao|first5=Xin|last6=Duan|first6=Zongtao|date=2020|title=Knowledge Graph Completion: A Review|journal=IEEE Access|volume=8|pages=192435–192456|doi=10.1109/ACCESS.2020.3030076|s2cid=226230006|issn=2169-3536|doi-access=free}}</ref> किसी मॉडल की सभी रैंक की गई भविष्यवाणियों के सेट के रूप में <chem>Q</chem> को देखते हुए, तीन अलग-अलग प्रदर्शन सूचकांकों को परिभाषित करना संभव है: Hits@K, MR, और MRR।<ref name=":31" /> | इन सूचकांकों का उपयोग प्रायः किसी मॉडल की एम्बेडिंग गुणवत्ता को मापने के लिए किया जाता है। सूचकांकों की सरलता उन्हें बड़े पैमाने पर भी एम्बेडिंग एल्गोरिदम के प्रदर्शन का मूल्यांकन करने के लिए बहुत उपयुक्त बनाती है।<ref name=":31">{{Cite journal|last1=Chen|first1=Zhe|last2=Wang|first2=Yuehan|last3=Zhao|first3=Bin|last4=Cheng|first4=Jing|last5=Zhao|first5=Xin|last6=Duan|first6=Zongtao|date=2020|title=Knowledge Graph Completion: A Review|journal=IEEE Access|volume=8|pages=192435–192456|doi=10.1109/ACCESS.2020.3030076|s2cid=226230006|issn=2169-3536|doi-access=free}}</ref> किसी मॉडल की सभी रैंक की गई भविष्यवाणियों के सेट के रूप में <chem>Q</chem> को देखते हुए, तीन अलग-अलग प्रदर्शन सूचकांकों को परिभाषित करना संभव है: Hits@K, MR, और MRR।<ref name=":31" /> | ||

==== Hits@K ==== | ==== Hits@K ==== | ||

Hits@K या संक्षेप में, H@K, प्रदर्शन सूचकांक है जो पहले शीर्ष के मॉडल भविष्यवाणियों में उचित भविष्यवाणी खोजने की संभावना को मापता है।<ref name=":31" /> सामान्यतः इसका प्रयोग <math>k=10</math> किया जाता है।<ref name=":31" /> Hits@K दो दिए गए ट्रिपल के बीच संबंध की उचित भविष्यवाणी करने के लिए एम्बेडिंग मॉडल की | Hits@K या संक्षेप में, H@K, प्रदर्शन सूचकांक है जो पहले शीर्ष के मॉडल भविष्यवाणियों में उचित भविष्यवाणी खोजने की संभावना को मापता है।<ref name=":31" /> सामान्यतः इसका प्रयोग <math>k=10</math> किया जाता है।<ref name=":31" /> Hits@K दो दिए गए ट्रिपल के बीच संबंध की उचित भविष्यवाणी करने के लिए एम्बेडिंग मॉडल की यथार्थता को दर्शाता है।<ref name=":31" /> | ||

Hits@K<math>= \frac{|\{q \in Q : q < k \}|}{|Q|} \in [0, 1]</math> | Hits@K<math>= \frac{|\{q \in Q : q < k \}|}{|Q|} \in [0, 1]</math> | ||

बड़े | |||

बड़े मानों का अर्थ स्पष्ट अनुमानित प्रदर्शन है।<ref name=":31" /> | |||

==== औसत रैंक (एमआर) ==== | ==== औसत रैंक (एमआर) ==== | ||

औसत रैंक सभी संभावित वस्तुओं के बीच मॉडल द्वारा अनुमानित वस्तुओं की औसत रैंकिंग स्थिति है।<ref name=":31" /> | |||

<math>MR = \frac{1}{|Q|}\sum_{q \in Q}{q}</math> | <math>MR = \frac{1}{|Q|}\sum_{q \in Q}{q}</math> | ||

मान जितना छोटा होगा, मॉडल उतना ही स्पष्ट होगा।<ref name=":31" /> | |||

==== माध्य पारस्परिक रैंक (एमआरआर) ==== | ==== माध्य पारस्परिक रैंक (एमआरआर) ==== | ||

माध्य पारस्परिक रैंक उचित | माध्य पारस्परिक रैंक उचित रूप से अनुमानित ट्रिपल की संख्या को मापता है।<ref name=":31" /> यदि पहला अनुमानित ट्रिपल उचित है, तो 1 जोड़ा जाता है, यदि दूसरा उचित है तो <math>\frac{1}{2}</math> का योग किया जाता है, और इसी प्रकार।<ref name=":31" /> | ||

औसत पारस्परिक रैंक का उपयोग सामान्यतः खोज एल्गोरिदम के प्रभाव को मापने के लिए किया जाता है।<ref name=":31" /> | औसत पारस्परिक रैंक का उपयोग सामान्यतः खोज एल्गोरिदम के प्रभाव को मापने के लिए किया जाता है।<ref name=":31" /> | ||

<math>MRR = \frac{1}{|Q|}\sum_{q \in Q}{\frac{1}{q}} \in [0, 1]</math> | <math>MRR = \frac{1}{|Q|}\sum_{q \in Q}{\frac{1}{q}} \in [0, 1]</math> | ||

सूचकांक जितना बड़ा होगा, मॉडल उतना ही | |||

सूचकांक जितना बड़ा होगा, मॉडल उतना ही स्पष्ट होगा।<ref name=":31" /> | |||

== अनुप्रयोग == | == अनुप्रयोग == | ||

=== मशीन लर्निंग | === मशीन लर्निंग क्रिया === | ||

ज्ञान ग्राफ पूर्णता (केजीसी) एम्बेडेड ज्ञान ग्राफ प्रतिनिधित्व से ज्ञान का अनुमान लगाने के लिए तकनीकों का संग्रह है।<ref name=":35">{{cite arXiv|last1=Cai|first1=Hongyun|last2=Zheng|first2=Vincent W.|last3=Chang|first3=Kevin Chen-Chuan|date=2018-02-02|title=A Comprehensive Survey of Graph Embedding: Problems, Techniques and Applications|class=cs.AI|eprint=1709.07604}}</ref> विशेष रूप से, यह तकनीक लुप्त इकाई या संबंध का अनुमान लगाते हुए ट्रिपल को | ज्ञान ग्राफ पूर्णता (केजीसी) एम्बेडेड ज्ञान ग्राफ प्रतिनिधित्व से ज्ञान का अनुमान लगाने के लिए तकनीकों का संग्रह है।<ref name=":35">{{cite arXiv|last1=Cai|first1=Hongyun|last2=Zheng|first2=Vincent W.|last3=Chang|first3=Kevin Chen-Chuan|date=2018-02-02|title=A Comprehensive Survey of Graph Embedding: Problems, Techniques and Applications|class=cs.AI|eprint=1709.07604}}</ref> विशेष रूप से, यह तकनीक लुप्त इकाई या संबंध का अनुमान लगाते हुए ट्रिपल को पूर्ण करती है।<ref name=":35" /> संबंधित उप-क्रियाओं को लिंक या इकाई भविष्यवाणी (अर्थात, ट्रिपल की दूसरी इकाई और संबंध को देखते हुए एम्बेडिंग से इकाई का अनुमान लगाना), और संबंध भविष्यवाणी (अर्थात, दो इकाइयों को जोड़ने वाले सबसे प्रशंसनीय संबंध की भविष्यवाणी करना) नाम दिया गया है।<ref name=":35" /> | ||

ट्रिपल वर्गीकरण द्विआधारी वर्गीकरण समस्या है।<ref name=":0" />एक ट्रिपल को देखते हुए, प्रशिक्षित मॉडल एम्बेडिंग का उपयोग करके ट्रिपल की संभाव्यता का मूल्यांकन करता है ताकि यह निर्धारित किया जा सके कि ट्रिपल उचित है या अनुचित।<ref name=":35" />निर्णय मॉडल स्कोर फ़ंक्शन और दी गई सीमा के साथ किया जाता है।<ref name=":35" />क्लस्टरिंग अन्य एप्लिकेशन है जो 2डी स्पेस में समान सिमेंटिक इकाइयों के प्रतिनिधित्व को संक्षिप्त करने के लिए विरल ज्ञान ग्राफ के एम्बेडेड प्रतिनिधित्व का लाभ उठाता है।<ref name=":32" /> | ट्रिपल वर्गीकरण द्विआधारी वर्गीकरण समस्या है।<ref name=":0" /> एक ट्रिपल को देखते हुए, प्रशिक्षित मॉडल एम्बेडिंग का उपयोग करके ट्रिपल की संभाव्यता का मूल्यांकन करता है ताकि यह निर्धारित किया जा सके कि ट्रिपल उचित है या अनुचित।<ref name=":35" /> निर्णय मॉडल स्कोर फ़ंक्शन और दी गई सीमा के साथ किया जाता है।<ref name=":35" /> क्लस्टरिंग अन्य एप्लिकेशन है जो 2डी स्पेस में समान सिमेंटिक इकाइयों के प्रतिनिधित्व को संक्षिप्त करने के लिए विरल ज्ञान ग्राफ के एम्बेडेड प्रतिनिधित्व का लाभ उठाता है।<ref name=":32" /> | ||

=== वास्तविक संसार के अनुप्रयोग === | === वास्तविक संसार के अनुप्रयोग === | ||

कई अनुप्रयोगों में ज्ञान ग्राफ एम्बेडिंग का उपयोग | कई अनुप्रयोगों में ज्ञान ग्राफ एम्बेडिंग का उपयोग तीव्र से व्यापक हो रहा है। [[अनुशंसा प्रणाली]] की स्थिति में, ज्ञान ग्राफ एम्बेडिंग का उपयोग सामान्य सुदृढीकरण सीखने की सीमाओं को दूर कर सकता है।<ref name=":33">{{cite arXiv|last1=Zhou|first1=Sijin|last2=Dai|first2=Xinyi|last3=Chen|first3=Haokun|last4=Zhang|first4=Weinan|last5=Ren|first5=Kan|last6=Tang|first6=Ruiming|last7=He|first7=Xiuqiang|last8=Yu|first8=Yong|date=2020-06-18|title=नॉलेज ग्राफ-एन्हांस्ड रीइन्फोर्समेंट लर्निंग के माध्यम से इंटरैक्टिव अनुशंसा प्रणाली|class=cs.IR|eprint=2006.10389}}</ref><ref>{{Cite book|last1=Liu|first1=Chan|last2=Li|first2=Lun|last3=Yao|first3=Xiaolu|last4=Tang|first4=Lin|title=2019 IEEE International Conference on Computer Science and Educational Informatization (CSEI) |chapter=A Survey of Recommendation Algorithms Based on Knowledge Graph Embedding |date=August 2019|chapter-url=https://ieeexplore.ieee.org/document/8938875|pages=168–171|doi=10.1109/CSEI47661.2019.8938875|isbn=978-1-7281-2308-0|s2cid=209459928}}</ref> इस प्रकार की अनुशंसा प्रणाली को प्रशिक्षित करने के लिए उपयोगकर्ताओं से भारी मात्रा में सूचना की आवश्यकता होती है; यद्यपि, ज्ञान ग्राफ़ तकनीकें आइटम सहसंबंध के पूर्व ज्ञान पर पहले से ही बनाए गए ग्राफ़ का उपयोग करके और उससे अनुशंसा का अनुमान लगाने के लिए एम्बेडिंग का उपयोग करके इस समस्या का समाधान कर सकती हैं।<ref name=":33" />औषधि पुनर्प्रयोजन पहले से ही अनुमोदित दवा का उपयोग है, लेकिन चिकित्सीय उद्देश्य के लिए उस उद्देश्य से भिन्न होता है जिसके लिए इसे प्रारंभ में डिज़ाइन किया गया था।<ref name=":34">{{Cite journal|last1=Sosa|first1=Daniel N.|last2=Derry|first2=Alexander|last3=Guo|first3=Margaret|last4=Wei|first4=Eric|last5=Brinton|first5=Connor|last6=Altman|first6=Russ B.|date=2020|title=दुर्लभ बीमारियों में दवा के पुनरुत्पादन के अवसरों की पहचान के लिए एक साहित्य-आधारित ज्ञान ग्राफ एम्बेडिंग विधि|journal=Pacific Symposium on Biocomputing. Pacific Symposium on Biocomputing|volume=25|pages=463–474|issn=2335-6936|pmc=6937428|pmid=31797619}}</ref> बड़े पैमाने पर साहित्य और बायोमेडिकल डेटाबेस की उपलब्धता का लाभ उठाकर निर्मित बायोमेडिकल ज्ञान ग्राफ का उपयोग करके पहले से मौजूद दवा और बीमारी के बीच नवीन संबंध का अनुमान लगाने के लिए लिंक भविष्यवाणी के क्रिया का उपयोग करना संभव है।<ref name=":34" />ज्ञान ग्राफ एम्बेडिंग का उपयोग सामाजिक राजनीति के क्षेत्र में भी किया जा सकता है।<ref name=":32" /> | ||

== मॉडल == | == मॉडल == | ||

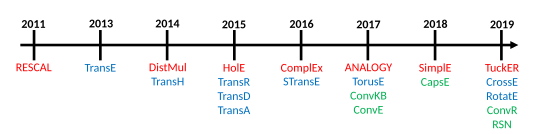

[[File:KG-Embedding.svg|thumb|कुछ ज्ञान ग्राफ एम्बेडिंग मॉडल की प्रकाशन समयरेखा। लाल रंग में टेंसर अपघटन मॉडल, नीले रंग में ज्यामितीय मॉडल और हरे रंग में गहन शिक्षण मॉडल। बचाव<ref name=":22" />(2011) पहला आधुनिक केजीई दृष्टिकोण था। में<ref>{{Cite book|last1=Nickel|first1=Maximilian|last2=Tresp|first2=Volker|last3=Kriegel|first3=Hans-Peter|title=Proceedings of the 21st international conference on World Wide Web |chapter=Factorizing YAGO |date=2012-04-16 |url=https://doi.org/10.1145/2187836.2187874 |publisher=Association for Computing Machinery|pages=271–280|doi=10.1145/2187836.2187874|isbn=978-1-4503-1229-5|s2cid=6348464}}</ref> इसे YAGO ज्ञान ग्राफ पर लागू किया गया था। यह बड़े पैमाने पर ज्ञान ग्राफ के लिए KGE का पहला अनुप्रयोग था।|535x535px]]ट्रिपल (या तथ्यों) का संग्रह दिया गया <math>\mathcal{F} = \{<head, relation, tail>\}</math>ज्ञान ग्राफ एम्बेडिंग मॉडल, ज्ञान ग्राफ में मौजूद प्रत्येक इकाई और संबंध के लिए सतत सदिश प्रतिनिधित्व उत्पन्न करता है।<ref name=":3" /> <math>(h, r, t)</math> ट्रिपल का संगत एम्बेडिंग है <math>h,t \in {\rm I\!R}^{d}</math> और <math>r \in {\rm I\!R}^{k}</math> , कहाँ <math>d</math> एम्बेडिंग के लिए एम्बेडिंग आयाम है, और <math>k</math> रिश्तों के लिए.<ref name=":3" />किसी दिए गए मॉडल का स्कोर फ़ंक्शन द्वारा दर्शाया गया है <math>\mathcal{f}_{r}(h, t) | [[File:KG-Embedding.svg|thumb|कुछ ज्ञान ग्राफ एम्बेडिंग मॉडल की प्रकाशन समयरेखा। लाल रंग में टेंसर अपघटन मॉडल, नीले रंग में ज्यामितीय मॉडल और हरे रंग में गहन शिक्षण मॉडल। बचाव<ref name=":22" />(2011) पहला आधुनिक केजीई दृष्टिकोण था। में<ref>{{Cite book|last1=Nickel|first1=Maximilian|last2=Tresp|first2=Volker|last3=Kriegel|first3=Hans-Peter|title=Proceedings of the 21st international conference on World Wide Web |chapter=Factorizing YAGO |date=2012-04-16 |url=https://doi.org/10.1145/2187836.2187874 |publisher=Association for Computing Machinery|pages=271–280|doi=10.1145/2187836.2187874|isbn=978-1-4503-1229-5|s2cid=6348464}}</ref> इसे YAGO ज्ञान ग्राफ पर लागू किया गया था। यह बड़े पैमाने पर ज्ञान ग्राफ के लिए KGE का पहला अनुप्रयोग था।|535x535px]]ट्रिपल (या तथ्यों) का संग्रह दिया गया <math>\mathcal{F} = \{<head, relation, tail>\}</math>ज्ञान ग्राफ एम्बेडिंग मॉडल, ज्ञान ग्राफ में मौजूद प्रत्येक इकाई और संबंध के लिए सतत सदिश प्रतिनिधित्व उत्पन्न करता है।<ref name=":3" /> <math>(h, r, t)</math> ट्रिपल का संगत एम्बेडिंग है <math>h,t \in {\rm I\!R}^{d}</math> और <math>r \in {\rm I\!R}^{k}</math> , कहाँ <math>d</math> एम्बेडिंग के लिए एम्बेडिंग आयाम है, और <math>k</math> रिश्तों के लिए.<ref name=":3" />किसी दिए गए मॉडल का स्कोर फ़ंक्शन द्वारा दर्शाया गया है <math>\mathcal{f}_{r}(h, t) | ||

| Line 69: | Line 72: | ||

रॉसी एट अल. एम्बेडिंग मॉडल की वर्गीकरण का प्रस्ताव करें और मॉडल के तीन मुख्य परिवारों की पहचान करें: टेंसर अपघटन मॉडल, ज्यामितीय मॉडल और गहन शिक्षण मॉडल।<ref name=":1" /> | रॉसी एट अल. एम्बेडिंग मॉडल की वर्गीकरण का प्रस्ताव करें और मॉडल के तीन मुख्य परिवारों की पहचान करें: टेंसर अपघटन मॉडल, ज्यामितीय मॉडल और गहन शिक्षण मॉडल।<ref name=":1" /> | ||

=== टेंसर अपघटन मॉडल === | === टेंसर अपघटन मॉडल === | ||

टेंसर अपघटन ज्ञान ग्राफ एम्बेडिंग मॉडल का परिवार है जो ज्ञान ग्राफ का प्रतिनिधित्व करने के लिए बहु-आयामी मैट्रिक्स का उपयोग करता है,<ref name=":0" /><ref name=":1" /><ref name=":25" />यह किसी विशेष डोमेन का | टेंसर अपघटन ज्ञान ग्राफ एम्बेडिंग मॉडल का परिवार है जो ज्ञान ग्राफ का प्रतिनिधित्व करने के लिए बहु-आयामी मैट्रिक्स का उपयोग करता है,<ref name=":0" /><ref name=":1" /><ref name=":25" />यह किसी विशेष डोमेन का पूर्ण रूप से वर्णन करने वाले ज्ञान ग्राफ के अंतराल के कारण आंशिक रूप से जानने योग्य है।<ref name=":1" />विशेष रूप से, ये मॉडल तीन-तरफा (3डी) [[ टेन्सर |टेन्सर]] का उपयोग करते हैं, जिसे बाद में निम्न-आयामी सदिश में विभाजित किया जाता है जो कि इकाइयां और संबंध एम्बेडिंग होते हैं।<ref name=":1" /><ref name=":25" />तीसरे क्रम का टेंसर ज्ञान ग्राफ का प्रतिनिधित्व करने के लिए उपयुक्त पद्धति है क्योंकि यह केवल एम्बेडिंग के बीच संबंध के अस्तित्व या अनुपस्थिति को रिकॉर्ड करता है,<ref name=":25" />और इस कारण से यह सरल है, और नेटवर्क संरचना को प्राथमिकता से जानने की कोई आवश्यकता नहीं है,<ref name=":22">{{Cite book|last1=Nickel|first1=Maximilian|last2=Tresp|first2=Volker|last3=Kriegel|first3=Hans-Peter|chapter=A three-way model for collective learning on multi-relational data |date=2011-06-28 |chapter-url=https://dl.acm.org/doi/10.5555/3104482.3104584 |title=ICML'11: Proceedings of the 28th International Conference on International Conference on Machine Learning|publisher=Omnipress|pages=809–816|doi=|isbn=978-1-4503-0619-5}}</ref> एम्बेडिंग मॉडल के इस वर्ग को हल्का और प्रशिक्षित करना आसान बनाता है, भले ही वे उच्च-आयामी और डेटा की विरलता से पीड़ित हों।<ref name=":1" /><ref name=":25" /> | ||

==== द्विरेखीय मॉडल ==== | ==== द्विरेखीय मॉडल ==== | ||

मॉडलों का यह परिवार संबंध के माध्यम से एम्बेडिंग के बीच संबंध को एम्बेड करने के लिए रैखिक समीकरण का उपयोग करता है।<ref name=":0" />विशेष रूप से, संबंधों का अंतर्निहित प्रतिनिधित्व द्विआयामी मैट्रिक्स है।<ref name=":1" />ये मॉडल, एम्बेडिंग प्रक्रिया के दौरान, एम्बेडेड प्रतिनिधित्व की गणना करने के लिए केवल एकल तथ्यों का उपयोग करते हैं और उसी इकाई या संबंध के अन्य संघों को अनदेखा करते हैं।<ref name=":4">{{Cite journal|last1=Wang|first1=Meihong|last2=Qiu|first2=Linling|last3=Wang|first3=Xiaoli|date=2021-03-16|title=लिंक भविष्यवाणी के लिए ज्ञान ग्राफ एंबेडिंग पर एक सर्वेक्षण|journal=Symmetry|language=en|volume=13|issue=3|pages=485|doi=10.3390/sym13030485|bibcode=2021Symm...13..485W|issn=2073-8994|doi-access=free}}</ref> * DistMult<ref name=":11">{{cite arXiv|last1=Yang|first1=Bishan|last2=Yih|first2=Wen-tau|last3=He|first3=Xiaodong|last4=Gao|first4=Jianfeng|last5=Deng|first5=Li|date=2015-08-29|title=ज्ञान के आधारों में सीखने और अनुमान के लिए संस्थाओं और संबंधों को एम्बेड करना|class=cs.CL|eprint=1412.6575}}</ref>: चूंकि संबंध का एम्बेडिंग मैट्रिक्स विकर्ण मैट्रिक्स है,<ref name=":1" />स्कोरिंग फ़ंक्शन असममित तथ्यों को अलग नहीं कर सकता है।<ref name=":1" /><ref name=":4" /> | मॉडलों का यह परिवार संबंध के माध्यम से एम्बेडिंग के बीच संबंध को एम्बेड करने के लिए रैखिक समीकरण का उपयोग करता है।<ref name=":0" />विशेष रूप से, संबंधों का अंतर्निहित प्रतिनिधित्व द्विआयामी मैट्रिक्स है।<ref name=":1" />ये मॉडल, एम्बेडिंग प्रक्रिया के दौरान, एम्बेडेड प्रतिनिधित्व की गणना करने के लिए केवल एकल तथ्यों का उपयोग करते हैं और उसी इकाई या संबंध के अन्य संघों को अनदेखा करते हैं।<ref name=":4">{{Cite journal|last1=Wang|first1=Meihong|last2=Qiu|first2=Linling|last3=Wang|first3=Xiaoli|date=2021-03-16|title=लिंक भविष्यवाणी के लिए ज्ञान ग्राफ एंबेडिंग पर एक सर्वेक्षण|journal=Symmetry|language=en|volume=13|issue=3|pages=485|doi=10.3390/sym13030485|bibcode=2021Symm...13..485W|issn=2073-8994|doi-access=free}}</ref> * DistMult<ref name=":11">{{cite arXiv|last1=Yang|first1=Bishan|last2=Yih|first2=Wen-tau|last3=He|first3=Xiaodong|last4=Gao|first4=Jianfeng|last5=Deng|first5=Li|date=2015-08-29|title=ज्ञान के आधारों में सीखने और अनुमान के लिए संस्थाओं और संबंधों को एम्बेड करना|class=cs.CL|eprint=1412.6575}}</ref>: चूंकि संबंध का एम्बेडिंग मैट्रिक्स विकर्ण मैट्रिक्स है,<ref name=":1" />स्कोरिंग फ़ंक्शन असममित तथ्यों को अलग नहीं कर सकता है।<ref name=":1" /><ref name=":4" /> | ||

* जटिल<ref name=":5">{{cite arXiv|last1=Trouillon|first1=Théo|last2=Welbl|first2=Johannes|last3=Riedel|first3=Sebastian|last4=Gaussier|first4=Éric|last5=Bouchard|first5=Guillaume|date=2016-06-20|title=सरल लिंक भविष्यवाणी के लिए जटिल एंबेडिंग|class=cs.AI|eprint=1606.06357}}</ref>: चूंकि DistMult एम्बेडिंग संबंधों का प्रतिनिधित्व करने के लिए विकर्ण मैट्रिक्स का उपयोग करता है लेकिन जटिल सदिश स्पेस और [[हर्मिटियन उत्पाद]] में प्रतिनिधित्व जोड़ता है, यह सममित और असममित तथ्यों को अलग कर सकता है।<ref name=":1" /><ref name=":25">{{Cite journal|last1=Alshahrani|first1=Mona|last2=Thafar|first2=Maha A.|last3=Essack|first3=Magbubah|date=2021-02-18|title=बायोमेडिकल डेटा में ज्ञान ग्राफ एम्बेडिंग का अनुप्रयोग और मूल्यांकन|journal=PeerJ Computer Science|language=en|volume=7|pages=e341|doi=10.7717/peerj-cs.341|issn=2376-5992|pmc=7959619|pmid=33816992 |doi-access=free }}</ref> यह दृष्टिकोण समय और समष्टि लागत के संदर्भ में बड़े ज्ञान ग्राफ के लिए स्केलेबल है।<ref name=":5" /> | * जटिल<ref name=":5">{{cite arXiv|last1=Trouillon|first1=Théo|last2=Welbl|first2=Johannes|last3=Riedel|first3=Sebastian|last4=Gaussier|first4=Éric|last5=Bouchard|first5=Guillaume|date=2016-06-20|title=सरल लिंक भविष्यवाणी के लिए जटिल एंबेडिंग|class=cs.AI|eprint=1606.06357}}</ref>: चूंकि DistMult एम्बेडिंग संबंधों का प्रतिनिधित्व करने के लिए विकर्ण मैट्रिक्स का उपयोग करता है लेकिन जटिल सदिश स्पेस और [[हर्मिटियन उत्पाद]] में प्रतिनिधित्व जोड़ता है, यह सममित और असममित तथ्यों को अलग कर सकता है।<ref name=":1" /><ref name=":25">{{Cite journal|last1=Alshahrani|first1=Mona|last2=Thafar|first2=Maha A.|last3=Essack|first3=Magbubah|date=2021-02-18|title=बायोमेडिकल डेटा में ज्ञान ग्राफ एम्बेडिंग का अनुप्रयोग और मूल्यांकन|journal=PeerJ Computer Science|language=en|volume=7|pages=e341|doi=10.7717/peerj-cs.341|issn=2376-5992|pmc=7959619|pmid=33816992 |doi-access=free }}</ref> यह दृष्टिकोण समय और समष्टि लागत के संदर्भ में बड़े ज्ञान ग्राफ के लिए स्केलेबल है।<ref name=":5" /> | ||

* सादृश्य<ref name=":12">{{cite arXiv|last1=Liu|first1=Hanxiao|last2=Wu|first2=Yuexin|last3=Yang|first3=Yiming|date=2017-07-06|title=बहु-संबंधपरक एंबेडिंग के लिए अनुरूप अनुमान|class=cs.LG|eprint=1705.02426}}</ref>: यह मॉडल आगमनात्मक तर्क को अनुकरण करने के लिए ज्ञान ग्राफ की अनुरूप संरचना को एम्बेड करने में एन्कोड करता है।<ref name=":12" /><ref name=":1" /><ref name=":0" />एक भिन्न उद्देश्य फ़ंक्शन का उपयोग करते हुए, ANALOGY में अच्छी सैद्धांतिक व्यापकता और कम्प्यूटेशनल स्केलेबिलिटी है।<ref name=":12" />यह सिद्ध है कि ANALOGY द्वारा निर्मित एम्बेडिंग DistMult, ComplEx, और HolE की एम्बेडिंग को | * सादृश्य<ref name=":12">{{cite arXiv|last1=Liu|first1=Hanxiao|last2=Wu|first2=Yuexin|last3=Yang|first3=Yiming|date=2017-07-06|title=बहु-संबंधपरक एंबेडिंग के लिए अनुरूप अनुमान|class=cs.LG|eprint=1705.02426}}</ref>: यह मॉडल आगमनात्मक तर्क को अनुकरण करने के लिए ज्ञान ग्राफ की अनुरूप संरचना को एम्बेड करने में एन्कोड करता है।<ref name=":12" /><ref name=":1" /><ref name=":0" />एक भिन्न उद्देश्य फ़ंक्शन का उपयोग करते हुए, ANALOGY में अच्छी सैद्धांतिक व्यापकता और कम्प्यूटेशनल स्केलेबिलिटी है।<ref name=":12" />यह सिद्ध है कि ANALOGY द्वारा निर्मित एम्बेडिंग DistMult, ComplEx, और HolE की एम्बेडिंग को पूर्ण रूप से पुनर्प्राप्त करती है।<ref name=":12" />* सरल<ref name=":13">{{cite arXiv|last1=Kazemi|first1=Seyed Mehran|last2=Poole|first2=David|date=2018-10-25|title=ज्ञान ग्राफ़ में लिंक भविष्यवाणी के लिए सरल एम्बेडिंग|class=stat.ML|eprint=1802.04868}}</ref>: यह मॉडल [[विहित बहुपद अपघटन]] (सीपी) का सुधार है, जिसमें संबंध के लिए एम्बेडिंग सदिश और प्रत्येक इकाई के लिए दो स्वतंत्र एम्बेडिंग सदिश सीखे जाते हैं, यह इस पर निर्भर करता है कि यह ज्ञान ग्राफ तथ्य में हेड या टेल है या नहीं।<ref name=":13" />SimpleE व्युत्क्रम संबंध का उपयोग करके दो इकाई एम्बेडिंग की स्वतंत्र सीखने की समस्या का समाधान करता है और सीपी स्कोर का औसत निकालता है <math>(h, r, t)</math> और <math>(t, r^{-1}, h)</math>.<ref name=":3" /><ref name=":25" />इस प्रकार, SimpleE एम्बेडिंग के बीच संबंध एकत्र करता है जबकि वे किसी तथ्य के अंदर विषय या वस्तु की भूमिका में दिखाई देते हैं, और यह असममित संबंधों को एम्बेड करने में सक्षम है।<ref name=":1" /> | ||

==== गैर-द्विरेखीय मॉडल ==== | ==== गैर-द्विरेखीय मॉडल ==== | ||

* छेद:<ref name=":14">{{cite arXiv|last1=Nickel|first1=Maximilian|last2=Rosasco|first2=Lorenzo|last3=Poggio|first3=Tomaso|date=2015-12-07|title=ज्ञान ग्राफ़ की होलोग्राफ़िक एंबेडिंग|class=cs.AI|eprint=1510.04935}}</ref> ज्ञान ग्राफ का एम्बेडेड प्रतिनिधित्व बनाने के लिए HolE परिपत्र सहसंबंध का उपयोग करता है,<ref name=":14" />जिसे मैट्रिक्स उत्पाद के संपीड़न के रूप में देखा जा सकता है, लेकिन असममित संबंध व्यक्त करने की क्षमताओं को बनाए रखते हुए अधिक कम्प्यूटेशनल रूप से कुशल और स्केलेबल है क्योंकि परिपत्र सहसंबंध क्रमविनिमेय नहीं है।<ref name=":4" />HolE होलोग्राफिक और जटिल एम्बेडिंग को जोड़ता है, यदि [[फूरियर रूपांतरण]] के साथ साथ उपयोग किया जाता है, तो इसे ComplEx के विशेष मामले के रूप में देखा जा सकता है।<ref name=":0" />* टकर:<ref name=":15">{{Cite book|last1=Balažević|first1=Ivana|last2=Allen|first2=Carl|last3=Hospedales|first3=Timothy M.|title=Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP) |chapter=TuckER: Tensor Factorization for Knowledge Graph Completion |date=2019 |pages=5184–5193|doi=10.18653/v1/D19-1522|arxiv=1901.09590|s2cid=59316623}}</ref> टकर ज्ञान ग्राफ को टेंसर के रूप में देखता है जिसे सदिश के संग्रह में [[टकर अपघटन]] का उपयोग करके विघटित किया जा सकता है{{emdash}}अर्थात, एम्बेडिंग और संबंधों का एम्बेडिंग{{emdash}}साझा कोर के साथ।<ref name=":15" /><ref name=":1" />कोर टेंसर का वजन एम्बेडिंग के साथ मिलकर सीखा जाता है और प्रविष्टियों के इंटरैक्शन के स्तर का प्रतिनिधित्व करता है।<ref name=":26">{{cite journal|last1=Ali|first1=Mehdi|last2=Berrendorf|first2=Max|last3=Hoyt|first3=Charles Tapley|last4=Vermue|first4=Laurent|last5=Galkin|first5=Mikhail|last6=Sharifzadeh|first6=Sahand|last7=Fischer|first7=Asja|last8=Tresp|first8=Volker|last9=Lehmann|first9=Jens|title=Bringing Light into the Dark: A Large-scale Evaluation of Knowledge Graph Embedding Models under a Unified Framework|journal=IEEE Transactions on Pattern Analysis and Machine Intelligence|year=2021|volume=PP|issue=12 |pages=8825–8845 |doi=10.1109/TPAMI.2021.3124805|pmid=34735335|arxiv=2006.13365|s2cid=220041612}}</ref> प्रत्येक इकाई और संबंध का अपना एम्बेडिंग आयाम होता है, और कोर टेंसर का आकार परस्पर क्रिया करने वाली एम्बेडिंग और संबंधों के आकार से निर्धारित होता है।<ref name=":1" />किसी तथ्य के विषय और वस्तु के एम्बेडिंग को उसी | * छेद:<ref name=":14">{{cite arXiv|last1=Nickel|first1=Maximilian|last2=Rosasco|first2=Lorenzo|last3=Poggio|first3=Tomaso|date=2015-12-07|title=ज्ञान ग्राफ़ की होलोग्राफ़िक एंबेडिंग|class=cs.AI|eprint=1510.04935}}</ref> ज्ञान ग्राफ का एम्बेडेड प्रतिनिधित्व बनाने के लिए HolE परिपत्र सहसंबंध का उपयोग करता है,<ref name=":14" />जिसे मैट्रिक्स उत्पाद के संपीड़न के रूप में देखा जा सकता है, लेकिन असममित संबंध व्यक्त करने की क्षमताओं को बनाए रखते हुए अधिक कम्प्यूटेशनल रूप से कुशल और स्केलेबल है क्योंकि परिपत्र सहसंबंध क्रमविनिमेय नहीं है।<ref name=":4" />HolE होलोग्राफिक और जटिल एम्बेडिंग को जोड़ता है, यदि [[फूरियर रूपांतरण]] के साथ साथ उपयोग किया जाता है, तो इसे ComplEx के विशेष मामले के रूप में देखा जा सकता है।<ref name=":0" />* टकर:<ref name=":15">{{Cite book|last1=Balažević|first1=Ivana|last2=Allen|first2=Carl|last3=Hospedales|first3=Timothy M.|title=Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP) |chapter=TuckER: Tensor Factorization for Knowledge Graph Completion |date=2019 |pages=5184–5193|doi=10.18653/v1/D19-1522|arxiv=1901.09590|s2cid=59316623}}</ref> टकर ज्ञान ग्राफ को टेंसर के रूप में देखता है जिसे सदिश के संग्रह में [[टकर अपघटन]] का उपयोग करके विघटित किया जा सकता है{{emdash}}अर्थात, एम्बेडिंग और संबंधों का एम्बेडिंग{{emdash}}साझा कोर के साथ।<ref name=":15" /><ref name=":1" />कोर टेंसर का वजन एम्बेडिंग के साथ मिलकर सीखा जाता है और प्रविष्टियों के इंटरैक्शन के स्तर का प्रतिनिधित्व करता है।<ref name=":26">{{cite journal|last1=Ali|first1=Mehdi|last2=Berrendorf|first2=Max|last3=Hoyt|first3=Charles Tapley|last4=Vermue|first4=Laurent|last5=Galkin|first5=Mikhail|last6=Sharifzadeh|first6=Sahand|last7=Fischer|first7=Asja|last8=Tresp|first8=Volker|last9=Lehmann|first9=Jens|title=Bringing Light into the Dark: A Large-scale Evaluation of Knowledge Graph Embedding Models under a Unified Framework|journal=IEEE Transactions on Pattern Analysis and Machine Intelligence|year=2021|volume=PP|issue=12 |pages=8825–8845 |doi=10.1109/TPAMI.2021.3124805|pmid=34735335|arxiv=2006.13365|s2cid=220041612}}</ref> प्रत्येक इकाई और संबंध का अपना एम्बेडिंग आयाम होता है, और कोर टेंसर का आकार परस्पर क्रिया करने वाली एम्बेडिंग और संबंधों के आकार से निर्धारित होता है।<ref name=":1" />किसी तथ्य के विषय और वस्तु के एम्बेडिंग को उसी प्रकार से संक्षेपित किया जाता है, जिससे टकर पूर्ण रूप से अभिव्यंजक हो जाता है, और अन्य एम्बेडिंग मॉडल जैसे कि RESCAL, DistMult, ComplEx और SimplE को टकर के विशेष फॉर्मूलेशन के रूप में व्यक्त किया जा सकता है।<ref name=":15" />* साथ:<ref name=":36">{{Cite book |last1=Tran |first1=Hung Nghiep |last2=Takasu |first2=Atsuhiro |title=Proceedings of the European Conference on Artificial Intelligence (ECAI 2020) |chapter=Multi-Partition Embedding Interaction with Block Term Format for Knowledge Graph Completion |date=2020 |chapter-url=https://ebooks.iospress.nl/doi/10.3233/FAIA200173 |pages=833–840 |series=Frontiers in Artificial Intelligence and Applications |volume=325|publisher=IOS Press |doi=10.3233/FAIA200173|s2cid=220265751 }}</ref> एमईआई ब्लॉक टर्म टेंसर प्रारूप के साथ बहु-विभाजन एम्बेडिंग इंटरैक्शन तकनीक पेश करता है, जो सीपी अपघटन और टकर अपघटन का सामान्यीकरण है। यह एम्बेडिंग सदिश को कई विभाजनों में विभाजित करता है और ComplEx या SimpleE मॉडल जैसे निश्चित विशेष पैटर्न का उपयोग करने के बजाय डेटा से स्थानीय इंटरैक्शन पैटर्न सीखता है। यह एमईआई को इष्टतम दक्षता प्राप्त करने में सक्षम बनाता है - अभिव्यंजना व्यापार-बंद, न कि केवल पूर्ण रूप से अभिव्यंजक होना।<ref name=":36" />पिछले मॉडल जैसे TuckER, RESCAL, DistMult, ComplEx, और SimpleE MEI के उप-इष्टतम प्रतिबंधित विशेष मामले हैं। | ||

*एमईआईएम:<ref name=":37">{{Cite book |last1=Tran |first1=Hung-Nghiep |last2=Takasu |first2=Atsuhiro |title=आर्टिफिशियल इंटेलिजेंस पर इकतीसवें अंतर्राष्ट्रीय संयुक्त सम्मेलन की कार्यवाही|chapter=MEIM: Multi-partition Embedding Interaction Beyond Block Term Format for Efficient and Expressive Link Prediction |date=2022-07-16 |url=https://www.ijcai.org/proceedings/2022/314 |language=en |volume=3 |pages=2262–2269 |doi=10.24963/ijcai.2022/314|isbn=978-1-956792-00-3 |s2cid=250635995 }}</ref> एमईआईएम बहु-विभाजन एम्बेडिंग इंटरैक्शन के अलावा, एसेम्बल बूस्टिंग प्रभावों के लिए स्वतंत्र कोर टेंसर और अधिकतम-रैंक रिलेशनल मैपिंग के लिए सॉफ्ट ऑर्थोगोनलिटी को पेश करने के लिए ब्लॉक टर्म टेंसर प्रारूप से आगे जाता है। MEIM कई पिछले मॉडलों जैसे MEI और इसके सम्मिलित मॉडल, RotaE और QuatE को सामान्यीकृत करता है।<ref name=":37" />MEIN व्यवहार में अत्यधिक कुशल होते हुए भी अभिव्यंजना में सुधार करता है, जिससे इसे काफी छोटे मॉडल आकारों का उपयोग करके अच्छे परिणाम प्राप्त करने में मदद मिलती है। | *एमईआईएम:<ref name=":37">{{Cite book |last1=Tran |first1=Hung-Nghiep |last2=Takasu |first2=Atsuhiro |title=आर्टिफिशियल इंटेलिजेंस पर इकतीसवें अंतर्राष्ट्रीय संयुक्त सम्मेलन की कार्यवाही|chapter=MEIM: Multi-partition Embedding Interaction Beyond Block Term Format for Efficient and Expressive Link Prediction |date=2022-07-16 |url=https://www.ijcai.org/proceedings/2022/314 |language=en |volume=3 |pages=2262–2269 |doi=10.24963/ijcai.2022/314|isbn=978-1-956792-00-3 |s2cid=250635995 }}</ref> एमईआईएम बहु-विभाजन एम्बेडिंग इंटरैक्शन के अलावा, एसेम्बल बूस्टिंग प्रभावों के लिए स्वतंत्र कोर टेंसर और अधिकतम-रैंक रिलेशनल मैपिंग के लिए सॉफ्ट ऑर्थोगोनलिटी को पेश करने के लिए ब्लॉक टर्म टेंसर प्रारूप से आगे जाता है। MEIM कई पिछले मॉडलों जैसे MEI और इसके सम्मिलित मॉडल, RotaE और QuatE को सामान्यीकृत करता है।<ref name=":37" />MEIN व्यवहार में अत्यधिक कुशल होते हुए भी अभिव्यंजना में सुधार करता है, जिससे इसे काफी छोटे मॉडल आकारों का उपयोग करके अच्छे परिणाम प्राप्त करने में मदद मिलती है। | ||

| Line 88: | Line 91: | ||

मॉडलों का यह वर्ग Word2vec में पेश किए गए अनुवाद अपरिवर्तनीयता के विचार से प्रेरित है।<ref name=":3" />एक शुद्ध अनुवादात्मक मॉडल इस तथ्य पर निर्भर करता है कि इकाइयों के एम्बेडिंग सदिश ज्यामितीय समष्टि में उचित संबंधपरक अनुवाद लागू करने के बाद एक-दूसरे के करीब होते हैं जिसमें उन्हें परिभाषित किया जाता है।<ref name=":4" />दूसरे शब्दों में, तथ्य को देखते हुए, जब संबंध के एम्बेडिंग में हेड का एम्बेडिंग जोड़ा जाता है, तो अपेक्षित परिणाम टेल का एम्बेडिंग होना चाहिए।<ref name=":1" />एम्बेडिंग एम्बेडिंग की निकटता कुछ दूरी माप द्वारा दी जाती है और किसी तथ्य की विश्वसनीयता को निर्धारित करती है।<ref name=":25" />फ़ाइल:TransE.pdf|thumb|TransE एम्बेडिंग मॉडल। हेड का सदिश प्रतिनिधित्व (एम्बेडिंग) और संबंध का सदिश प्रतिनिधित्व टेल इकाई के सदिश प्रतिनिधित्व के बराबर होना चाहिए। | मॉडलों का यह वर्ग Word2vec में पेश किए गए अनुवाद अपरिवर्तनीयता के विचार से प्रेरित है।<ref name=":3" />एक शुद्ध अनुवादात्मक मॉडल इस तथ्य पर निर्भर करता है कि इकाइयों के एम्बेडिंग सदिश ज्यामितीय समष्टि में उचित संबंधपरक अनुवाद लागू करने के बाद एक-दूसरे के करीब होते हैं जिसमें उन्हें परिभाषित किया जाता है।<ref name=":4" />दूसरे शब्दों में, तथ्य को देखते हुए, जब संबंध के एम्बेडिंग में हेड का एम्बेडिंग जोड़ा जाता है, तो अपेक्षित परिणाम टेल का एम्बेडिंग होना चाहिए।<ref name=":1" />एम्बेडिंग एम्बेडिंग की निकटता कुछ दूरी माप द्वारा दी जाती है और किसी तथ्य की विश्वसनीयता को निर्धारित करती है।<ref name=":25" />फ़ाइल:TransE.pdf|thumb|TransE एम्बेडिंग मॉडल। हेड का सदिश प्रतिनिधित्व (एम्बेडिंग) और संबंध का सदिश प्रतिनिधित्व टेल इकाई के सदिश प्रतिनिधित्व के बराबर होना चाहिए। | ||

* ट्रांसई<ref name=":9">{{Cite book|last1=Bordes|first1=Antoine|last2=Usunier|first2=Nicolas|last3=Garcia-Durán|first3=Alberto|last4=Weston|first4=Jason|last5=Yakhnenko|first5=Oksana|chapter=Translating embeddings for modeling multi-relational data |date=May 2013 |chapter-url=https://dl.acm.org/doi/10.5555/2999792.2999923 |title=NIPS'13: Proceedings of the 26th International Conference on Neural Information Processing Systems |publisher=Curran Associates Inc.|pages=2787–2795}}</ref>: यह मॉडल स्कोरिंग फ़ंक्शन का उपयोग करता है जो एम्बेडिंग को प्रत्येक तथ्य में साधारण [[वेक्टर योग|सदिश योग]] समीकरण को संतुष्ट करने के लिए मजबूर करता है जिसमें वे दिखाई देते हैं: <math>h + r = t</math>.<ref name=":3" />एम्बेडिंग | * ट्रांसई<ref name=":9">{{Cite book|last1=Bordes|first1=Antoine|last2=Usunier|first2=Nicolas|last3=Garcia-Durán|first3=Alberto|last4=Weston|first4=Jason|last5=Yakhnenko|first5=Oksana|chapter=Translating embeddings for modeling multi-relational data |date=May 2013 |chapter-url=https://dl.acm.org/doi/10.5555/2999792.2999923 |title=NIPS'13: Proceedings of the 26th International Conference on Neural Information Processing Systems |publisher=Curran Associates Inc.|pages=2787–2795}}</ref>: यह मॉडल स्कोरिंग फ़ंक्शन का उपयोग करता है जो एम्बेडिंग को प्रत्येक तथ्य में साधारण [[वेक्टर योग|सदिश योग]] समीकरण को संतुष्ट करने के लिए मजबूर करता है जिसमें वे दिखाई देते हैं: <math>h + r = t</math>.<ref name=":3" />एम्बेडिंग यथार्थ होगी यदि प्रत्येक इकाई और संबंध केवल ही तथ्य में प्रकट होता है, और, इस कारण से, व्यवहार में [[एक-से-अनेक (डेटा मॉडल)]] | एक-से-अनेक, [[अनेक-से-एक संबंध]] का स्पष्ट रूप से प्रतिनिधित्व नहीं करता है |अनेक-से-एक, और [[असममित संबंध]] संबंध।<ref name=":1" /><ref name=":3" />अंश<ref name=":6">{{Cite book|last=Wang|first=Zhen|chapter=Knowledge Graph Embedding by Translating on Hyperplanes |title=आर्टिफिशियल इंटेलिजेंस पर एएएआई सम्मेलन की कार्यवाही|date=2014 |chapter-url=https://www.aaai.org/ocs/index.php/AAAI/AAAI14/paper/view/8531 |volume=28 |doi=10.1609/aaai.v28i1.8870 |s2cid=15027084 }}</ref>: यह संबंधों के प्रकारों को उचित रूप से प्रस्तुत करने की समस्या को हल करने के लिए [[हाइपरप्लेन]] को ज्यामितीय समष्टि के रूप में पेश करने वाले ट्रांसई का विकास है।<ref name=":6" />ट्रांसएच में, प्रत्येक संबंध का अलग हाइपरप्लेन पर अलग एम्बेडेड प्रतिनिधित्व होता है, यह इस पर आधारित होता है कि यह किन एम्बेडिंग के साथ इंटरैक्ट करता है।<ref name=":3" />इसलिए, उदाहरण के लिए, किसी तथ्य के स्कोर फ़ंक्शन की गणना करने के लिए, संबंध के उचित हाइपरप्लेन पर रिलेशनल प्रोजेक्शन मैट्रिक्स का उपयोग करके हेड और टेल के एम्बेडेड प्रतिनिधित्व को प्रक्षेपित करने की आवश्यकता होती है।<ref name=":0" /><ref name=":3" />* ट्रांसर<ref name=":10">{{Cite book|last1=Lin|first1=Yankai|last2=Liu|first2=Zhiyuan|last3=Sun|first3=Maosong|last4=Liu|first4=Yang|last5=Zhu|first5=Xuan|title=ज्ञान ग्राफ पूरा करने के लिए सीखने की इकाई और संबंध एम्बेडिंग|date=2015-01-25 |url=https://dl.acm.org/doi/10.5555/2886521.2886624 |publisher=AAAI Press|pages=2181–2187|isbn=978-0-262-51129-2}}</ref>: ट्रांसआर, ट्रांसएच का विकास है क्योंकि यह एम्बेडिंग और संबंधों के अंतर्निहित प्रतिनिधित्व का प्रतिनिधित्व करने के लिए दो अलग-अलग समष्टियों का उपयोग करता है,<ref name=":0" /><ref name=":4" />और एम्बेडिंग और संबंधों के शब्दार्थ समष्टि को पूर्ण रूप से अलग कर दें।<ref name=":3" />इसके अलावा ट्रांसआर इकाइयों के एम्बेडिंग को रिलेशन स्पेस में अनुवाद करने के लिए रिलेशनल प्रोजेक्शन मैट्रिक्स का उपयोग करता है।<ref name=":3" />*ट्रांसडी:<ref name=":7">{{Cite book|last1=Ji|first1=Guoliang|last2=He|first2=Shizhu|last3=Xu|first3=Liheng|last4=Liu|first4=Kang|last5=Zhao|first5=Jun|title=Proceedings of the 53rd Annual Meeting of the Association for Computational Linguistics and the 7th International Joint Conference on Natural Language Processing (Volume 1: Long Papers) |chapter=Knowledge Graph Embedding via Dynamic Mapping Matrix |date=July 2015|chapter-url=https://www.aclweb.org/anthology/P15-1067 |publisher=Association for Computational Linguistics|pages=687–696|doi=10.3115/v1/P15-1067|s2cid=11202498}}</ref>किसी तथ्य को देखते हुए, ट्रांसआर में, किसी तथ्य का सिर और पिछला हिस्सा दो अलग-अलग प्रकार की एम्बेडिंग से संबंधित हो सकता है, उदाहरण के लिए, तथ्य में<math>(Obama, president\_of, USA)</math>, ओबामा और यूएसए दो संस्थाएं हैं लेकिन व्यक्ति है और दूसरा देश है।<ref name=":7" /><ref name=":3" />प्रक्षेपण की गणना करने के लिए ट्रांसआर में मैट्रिक्स गुणन भी महंगी प्रक्रिया है।<ref name=":3" /><ref name=":7" />इस संदर्भ में, ट्रांसडी गतिशील मैपिंग की गणना करने के लिए प्रत्येक इकाई-संबंध जोड़ी के लिए दो सदिश को नियोजित करता है जो आयामी जटिलता को कम करते हुए प्रक्षेपण मैट्रिक्स को प्रतिस्थापित करता है।<ref name=":0" /><ref name=":3" /><ref name=":7" />पहले सदिश का उपयोग एम्बेडिंग और संबंधों के अर्थपूर्ण अर्थ को दर्शाने के लिए किया जाता है, दूसरे का उपयोग मैपिंग मैट्रिक्स की गणना करने के लिए किया जाता है।<ref name=":7" />*ट्रांसए:<ref name=":8">{{cite arXiv|last1=Xiao|first1=Han|last2=Huang|first2=Minlie|last3=Hao|first3=Yu|last4=Zhu|first4=Xiaoyan|date=2015-09-27|title=TransA: An Adaptive Approach for Knowledge Graph Embedding|class=cs.CL|eprint=1509.05490}}</ref> सभी अनुवादात्मक मॉडल अपने प्रतिनिधित्व समष्टि में स्कोर फ़ंक्शन को परिभाषित करते हैं, लेकिन वे इस मीट्रिक हानि को अधिक सरल बनाते हैं।<ref name=":8" />चूंकि एम्बेडिंग और संबंधों का सदिश प्रतिनिधित्व उचित नहीं है, इसलिए इसका शुद्ध अनुवाद <math>h + r</math> से दूर हो सकता है <math>t</math>, और [[गोलाकार]] समविभव [[यूक्लिडियन दूरी]] से यह भेद करना कठिन हो जाता है कि निकटतम इकाई कौन सी है।<ref name=":8" />इसके बजाय, ट्रांसए, अस्पष्टता को दूर करने के लिए दीर्घवृत्त सतहों के साथ, एम्बेडिंग आयामों को भारित करने के लिए अनुकूली महालनोबिस दूरी का परिचय देता है।<ref name=":0" /><ref name=":3" /><ref name=":8" /> | ||

==== अतिरिक्त एम्बेडिंग के साथ अनुवादात्मक मॉडल ==== | ==== अतिरिक्त एम्बेडिंग के साथ अनुवादात्मक मॉडल ==== | ||

ज्ञान ग्राफ में प्रत्येक तत्व और उनके सामान्य प्रतिनिधित्व तथ्यों के साथ अतिरिक्त सूचना जोड़ना संभव है।<ref name=":0" />ज्ञान ग्राफ के साथ डोमेन के समग्र विवरण को | ज्ञान ग्राफ में प्रत्येक तत्व और उनके सामान्य प्रतिनिधित्व तथ्यों के साथ अतिरिक्त सूचना जोड़ना संभव है।<ref name=":0" />ज्ञान ग्राफ के साथ डोमेन के समग्र विवरण को स्पष्ट बनाने के लिए प्रत्येक इकाई और संबंध को पाठ विवरण, भार, बाधाओं और अन्य से समृद्ध किया जा सकता है।<ref name=":0" />ज्ञान ग्राफ के एम्बेडिंग के दौरान, इस सूचना का उपयोग इन विशेषताओं के लिए विशेष एम्बेडिंग सीखने के लिए किया जा सकता है, साथ ही अधिक महत्वपूर्ण संख्या में सदिश सीखने की लागत के साथ, एम्बेडिंग और संबंधों के सामान्य एम्बेडेड प्रतिनिधित्व को भी सीखा जा सकता है।<ref name=":1" />* एसट्रांसई:<ref name=":16">{{Cite book|last1=Nguyen|first1=Dat Quoc|last2=Sirts|first2=Kairit|last3=Qu|first3=Lizhen|last4=Johnson|first4=Mark|title=Proceedings of the 2016 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies |chapter=STransE: A novel embedding model of entities and relationships in knowledge bases |date=June 2016 |chapter-url=https://www.aclweb.org/anthology/N16-1054 |publisher=Association for Computational Linguistics|pages=460–466|doi=10.18653/v1/N16-1054|arxiv=1606.08140|s2cid=9884935}}</ref> यह मॉडल ट्रांसई और संरचना एम्बेडिंग के संयोजन का परिणाम है<ref name=":16" />इस प्रकार यह एक-से-अनेक, अनेक-से-एक और अनेक-से-अनेक संबंधों का स्पष्ट प्रतिनिधित्व करने में सक्षम है।<ref name=":1" />ऐसा करने के लिए, मॉडल में दो अतिरिक्त स्वतंत्र मैट्रिक्स सम्मिलित हैं <math>W_{r}^{h}</math> और <math>W_{r}^{t}</math> प्रत्येक एम्बेडेड संबंध के लिए <math>r</math> केजी में.<ref name=":16" />प्रत्येक अतिरिक्त मैट्रिक्स का उपयोग इस तथ्य के आधार पर किया जाता है कि विशिष्ट संबंध तथ्य के सिर या पूंछ के साथ अन्तःक्रिया करता है।<ref name=":16" />दूसरे शब्दों में, तथ्य दिया गया है <math>(h, r, t)</math>, सदिश अनुवाद लागू करने से पहले, सिर <math>h</math> से गुणा किया जाता है <math>W_{r}^{h}</math> और पूँछ कई गुना बढ़ जाती है <math>W_{r}^{t}</math>.<ref name=":3" />* क्रॉसई'':<ref name=":17">{{Cite book|last1=Zhang|first1=Wen|last2=Paudel|first2=Bibek|last3=Zhang|first3=Wei|last4=Bernstein|first4=Abraham|last5=Chen|first5=Huajun|title=वेब खोज और डेटा माइनिंग पर बारहवें एसीएम अंतर्राष्ट्रीय सम्मेलन की कार्यवाही|chapter=Interaction Embeddings for Prediction and Explanation in Knowledge Graphs |date=2019-01-30 |pages=96–104|doi=10.1145/3289600.3291014|arxiv=1903.04750|isbn=9781450359405|s2cid=59516071}}</ref> ''क्रॉसओवर इंटरैक्शन का उपयोग संबंधित सूचना चयन के लिए किया जा सकता है, और एम्बेडिंग प्रक्रिया के लिए बहुत उपयोगी हो सकता है।<ref name=":17" />क्रॉसओवर इंटरैक्शन सूचना चयन में दो अलग-अलग योगदान प्रदान करते हैं: संबंधों से एम्बेडिंग तक इंटरैक्शन और एम्बेडिंग से संबंधों तक इंटरैक्शन।<ref name=":17" />इसका अर्थ यह है कि संबंध, उदाहरण के लिए 'President_of' स्वचालित रूप से उन एम्बेडिंग के प्रकार का चयन करता है जो विषय को किसी तथ्य की वस्तु से जोड़ रहे हैं।<ref name=":17" />इसी प्रकार, किसी तथ्य की इकाई अप्रत्यक्ष रूप से यह निर्धारित करती है कि संबंधित ट्रिपल की वस्तु की भविष्यवाणी करने के लिए कौन सा अनुमान पथ चुनना है।<ref name=":17" />क्रॉसई, ऐसा करने के लिए, अतिरिक्त इंटरैक्शन मैट्रिक्स सीखता है <math>C</math>, बीच की अन्तःक्रिया की गणना करने के लिए तत्व-वार उत्पाद का उपयोग करता है <math>h</math> और <math>r</math>.<ref name=":1" /><ref name=":17" />भले ही, क्रॉसई, तंट्रिपला नेटवर्क आर्किटेक्चर पर भरोसा नहीं करता है, यह दिखाया गया है कि इस पद्धति को ऐसे आर्किटेक्चर में एन्कोड किया जा सकता है।<ref name=":0" /> | ||

==== रोटो-अनुवादात्मक मॉडल ==== | ==== रोटो-अनुवादात्मक मॉडल ==== | ||

मॉडलों का यह परिवार, अनुवाद के अतिरिक्त या प्रतिस्थापन में रोटेशन-जैसे परिवर्तन को नियोजित करता है।<ref name=":1" />* लेना:<ref name=":18">{{cite arXiv|last1=Ebisu|first1=Takuma|last2=Ichise|first2=Ryutaro|date=2017-11-15|title=TorusE: Knowledge Graph Embedding on a Lie Group|class=cs.AI|eprint=1711.05435}}</ref> ट्रेडई का नियमितीकरण शब्द इकाई को गोलाकार समष्टि बनाने के लिए एम्बेड करता है, और परिणामस्वरूप ज्यामितीय समष्टि के अनुवाद गुणों को खो देता है।<ref name=":18" />इस समस्या का समाधान करने के लिए, [[ टोरस्र्स |टोरस्र्स]] ई कॉम्पैक्ट लाई समूह के उपयोग का लाभ उठाता है जो इस विशिष्ट मामले में एन-आयामी टोरस स्पेस है, और नियमितीकरण के उपयोग से बचता है।<ref name=":0" /><ref name=":18" />टोर्स ट्रांस के एल1 और एल2 मानदंड को प्रतिस्थापित करने के लिए दूरी फ़ंक्शन को परिभाषित करता है।<ref name=":1" />* घुमाएँ:<ref name=":19">{{cite arXiv|last1=Sun|first1=Zhiqing|last2=Deng|first2=Zhi-Hong|last3=Nie|first3=Jian-Yun|last4=Tang|first4=Jian|date=2019-02-26|title=RotatE: Knowledge Graph Embedding by Relational Rotation in Complex Space|class=cs.LG|eprint=1902.10197}}</ref> रोटेटई यूलर की पहचान से प्रेरित है और इसमें संबंध दर्शाने के लिए [[हैडामर्ड उत्पाद (मैट्रिसेस)]] का उपयोग सम्मिलित है <math>r</math> सिर से घुमाव के रूप में <math>h</math> पूँछ तक <math>t | मॉडलों का यह परिवार, अनुवाद के अतिरिक्त या प्रतिस्थापन में रोटेशन-जैसे परिवर्तन को नियोजित करता है।<ref name=":1" />* लेना:<ref name=":18">{{cite arXiv|last1=Ebisu|first1=Takuma|last2=Ichise|first2=Ryutaro|date=2017-11-15|title=TorusE: Knowledge Graph Embedding on a Lie Group|class=cs.AI|eprint=1711.05435}}</ref> ट्रेडई का नियमितीकरण शब्द इकाई को गोलाकार समष्टि बनाने के लिए एम्बेड करता है, और परिणामस्वरूप ज्यामितीय समष्टि के अनुवाद गुणों को खो देता है।<ref name=":18" />इस समस्या का समाधान करने के लिए, [[ टोरस्र्स |टोरस्र्स]] ई कॉम्पैक्ट लाई समूह के उपयोग का लाभ उठाता है जो इस विशिष्ट मामले में एन-आयामी टोरस स्पेस है, और नियमितीकरण के उपयोग से बचता है।<ref name=":0" /><ref name=":18" />टोर्स ट्रांस के एल1 और एल2 मानदंड को प्रतिस्थापित करने के लिए दूरी फ़ंक्शन को परिभाषित करता है।<ref name=":1" />* घुमाएँ:<ref name=":19">{{cite arXiv|last1=Sun|first1=Zhiqing|last2=Deng|first2=Zhi-Hong|last3=Nie|first3=Jian-Yun|last4=Tang|first4=Jian|date=2019-02-26|title=RotatE: Knowledge Graph Embedding by Relational Rotation in Complex Space|class=cs.LG|eprint=1902.10197}}</ref> रोटेटई यूलर की पहचान से प्रेरित है और इसमें संबंध दर्शाने के लिए [[हैडामर्ड उत्पाद (मैट्रिसेस)]] का उपयोग सम्मिलित है <math>r</math> सिर से घुमाव के रूप में <math>h</math> पूँछ तक <math>t | ||

</math> जटिल समष्टि में.<ref name=":19" />ट्रिपल के प्रत्येक तत्व के लिए, एम्बेडिंग का जटिल हिस्सा अक्ष के संबंध में वामावर्त रोटेशन का वर्णन करता है, जिसे यूलर की पहचान के साथ वर्णित किया जा सकता है, जबकि संबंध सदिश का मापांक 1 है।<ref name=":19" />यह दिखाया गया है कि मॉडल ज्ञान ग्राफ से सममित, असममित, उलटा और संरचना संबंधों को एम्बेड करने में सक्षम है।<ref name=":19" /> | </math> जटिल समष्टि में.<ref name=":19" />ट्रिपल के प्रत्येक तत्व के लिए, एम्बेडिंग का जटिल हिस्सा अक्ष के संबंध में वामावर्त रोटेशन का वर्णन करता है, जिसे यूलर की पहचान के साथ वर्णित किया जा सकता है, जबकि संबंध सदिश का मापांक 1 है।<ref name=":19" />यह दिखाया गया है कि मॉडल ज्ञान ग्राफ से सममित, असममित, उलटा और संरचना संबंधों को एम्बेड करने में सक्षम है।<ref name=":19" /> | ||

=== गहन शिक्षण मॉडल === | === गहन शिक्षण मॉडल === | ||

एम्बेडिंग मॉडल का यह समूह ज्ञान ग्राफ से पैटर्न सीखने के लिए गहरे तंट्रिपला नेटवर्क का उपयोग करता है जो इनपुट डेटा हैं।<ref name=":1" />इन मॉडलों में इकाई और संबंध के प्रकार, अस्थायी सूचना, पथ सूचना, अंतर्निहित संरचित सूचना को अलग करने की व्यापकता है।<ref name=":4" />और ज्ञान ग्राफ की सभी विशेषताओं का प्रतिनिधित्व करने में दूरी-आधारित और अर्थ-मिलान-आधारित मॉडल की सीमाओं को हल करें।<ref name=":0" />ज्ञान ग्राफ एम्बेडिंग के लिए गहन शिक्षण के उपयोग ने अच्छा | एम्बेडिंग मॉडल का यह समूह ज्ञान ग्राफ से पैटर्न सीखने के लिए गहरे तंट्रिपला नेटवर्क का उपयोग करता है जो इनपुट डेटा हैं।<ref name=":1" />इन मॉडलों में इकाई और संबंध के प्रकार, अस्थायी सूचना, पथ सूचना, अंतर्निहित संरचित सूचना को अलग करने की व्यापकता है।<ref name=":4" />और ज्ञान ग्राफ की सभी विशेषताओं का प्रतिनिधित्व करने में दूरी-आधारित और अर्थ-मिलान-आधारित मॉडल की सीमाओं को हल करें।<ref name=":0" />ज्ञान ग्राफ एम्बेडिंग के लिए गहन शिक्षण के उपयोग ने अच्छा अनुमानित प्रदर्शन दिखाया है, भले ही वे प्रशिक्षण चरण में अधिक महंगे हों, डेटा की कमी हो, और प्रायः अलग एम्बेडिंग मॉडल से आने वाले ज्ञान ग्राफ के पूर्व-प्रशिक्षित एम्बेडिंग प्रतिनिधित्व की आवश्यकता होती है।<ref name=":0" /><ref name=":1" /> | ||

==== संवादात्मक तंट्रिपला नेटवर्क ==== | ==== संवादात्मक तंट्रिपला नेटवर्क ==== | ||

मॉडलों का यह परिवार, | मॉडलों का यह परिवार, पूर्ण रूप से कनेक्टेड परतों का उपयोग करने के बजाय, या से अधिक कन्वेन्शनल परतों को नियोजित करता है जो कम-आयामी फ़िल्टर लागू करके इनपुट डेटा को संयोजित करता है जो नॉनलाइनियर सुविधाओं को सीखकर कुछ मापदंडों के साथ जटिल संरचनाओं को एम्बेड करने में सक्षम होता है।<ref name=":0" /><ref name=":1" /><ref name=":4" /> | ||

* कन्वे:<ref name=":29">{{cite arXiv|last1=Dettmers|first1=Tim|last2=Minervini|first2=Pasquale|last3=Stenetorp|first3=Pontus|last4=Riedel|first4=Sebastian|date=2018-07-04|title=Convolutional 2D Knowledge Graph Embeddings|class=cs.LG|eprint=1707.01476}}</ref> ConvE एम्बेडिंग मॉडल है जो गहन शिक्षण मॉडल और कम्प्यूटेशनल महँगेपन की अच्छी ट्रेडऑफ़ अभिव्यक्ति का प्रतिनिधित्व करता है,<ref name=":25" />वास्तव में यह दिखाया गया है कि DistMult की तुलना में इसमें 8x कम पैरामीटर का उपयोग किया गया है।<ref name=":29"/>ConvE एक-आयामी का उपयोग करता है <math>d</math>ज्ञान ग्राफ की एम्बेडिंग और संबंधों का प्रतिनिधित्व करने के लिए आकार का एम्बेडिंग।<ref name=":1" /><ref name=":29"/>ट्रिपल के स्कोर फ़ंक्शन की गणना करने के लिए, ConvE सरल प्रक्रिया लागू करता है: पहले कॉनकैटेन्स और ट्रिपल के प्रमुख और संबंध के एम्बेडिंग को ही डेटा में मर्ज करें <chem>[h; \mathcal{r}]</chem>, तो इस मैट्रिक्स का उपयोग 2डी कनवल्शनल परत के लिए इनपुट के रूप में किया जाता है।<ref name=":1" /><ref name=":25" />फिर परिणाम को घनी परत से गुजारा जाता है जो मैट्रिक्स द्वारा पैरामीटरयुक्त रैखिक परिवर्तन लागू करता है <math>\mathcal{W}</math> और अंत में, [[आंतरिक उत्पाद स्थान|आंतरिक उत्पाद]] समष्टि टेल ट्रिपल से जुड़ा हुआ है।<ref name=":1" /><ref name=":4" />ConvE मूल्यांकन प्रक्रिया में भी विशेष रूप से कुशल है: 1-एन स्कोरिंग का उपयोग करके, मॉडल मेल खाता है, हेड और संबंध दिया जाता है, ही समय में सभी टेल्स, 1-1 मूल्यांकन की तुलना में बहुत सारे मूल्यांकन समय बचाते हैं अन्य मॉडलों का कार्यक्रम.<ref name=":4" />* रूपांतरण:<ref name=":20">{{Cite book|last1=Jiang|first1=Xiaotian|last2=Wang|first2=Quan|last3=Wang|first3=Bin|title=Proceedings of the 2019 Conference of the North |chapter=Adaptive Convolution for Multi-Relational Learning |date=June 2019 |chapter-url=https://www.aclweb.org/anthology/N19-1103 |publisher=Association for Computational Linguistics|pages=978–987|doi=10.18653/v1/N19-1103|s2cid=174800352}}</ref> ConvR अनुकूली दृढ़ नेटवर्क है जिसका उद्देश्य एम्बेडिंग और संबंधों के बीच सभी संभावित इंटरैक्शन का गहराई से प्रतिनिधित्व करना है।<ref name=":20" />इस | * कन्वे:<ref name=":29">{{cite arXiv|last1=Dettmers|first1=Tim|last2=Minervini|first2=Pasquale|last3=Stenetorp|first3=Pontus|last4=Riedel|first4=Sebastian|date=2018-07-04|title=Convolutional 2D Knowledge Graph Embeddings|class=cs.LG|eprint=1707.01476}}</ref> ConvE एम्बेडिंग मॉडल है जो गहन शिक्षण मॉडल और कम्प्यूटेशनल महँगेपन की अच्छी ट्रेडऑफ़ अभिव्यक्ति का प्रतिनिधित्व करता है,<ref name=":25" />वास्तव में यह दिखाया गया है कि DistMult की तुलना में इसमें 8x कम पैरामीटर का उपयोग किया गया है।<ref name=":29"/>ConvE एक-आयामी का उपयोग करता है <math>d</math>ज्ञान ग्राफ की एम्बेडिंग और संबंधों का प्रतिनिधित्व करने के लिए आकार का एम्बेडिंग।<ref name=":1" /><ref name=":29"/>ट्रिपल के स्कोर फ़ंक्शन की गणना करने के लिए, ConvE सरल प्रक्रिया लागू करता है: पहले कॉनकैटेन्स और ट्रिपल के प्रमुख और संबंध के एम्बेडिंग को ही डेटा में मर्ज करें <chem>[h; \mathcal{r}]</chem>, तो इस मैट्रिक्स का उपयोग 2डी कनवल्शनल परत के लिए इनपुट के रूप में किया जाता है।<ref name=":1" /><ref name=":25" />फिर परिणाम को घनी परत से गुजारा जाता है जो मैट्रिक्स द्वारा पैरामीटरयुक्त रैखिक परिवर्तन लागू करता है <math>\mathcal{W}</math> और अंत में, [[आंतरिक उत्पाद स्थान|आंतरिक उत्पाद]] समष्टि टेल ट्रिपल से जुड़ा हुआ है।<ref name=":1" /><ref name=":4" />ConvE मूल्यांकन प्रक्रिया में भी विशेष रूप से कुशल है: 1-एन स्कोरिंग का उपयोग करके, मॉडल मेल खाता है, हेड और संबंध दिया जाता है, ही समय में सभी टेल्स, 1-1 मूल्यांकन की तुलना में बहुत सारे मूल्यांकन समय बचाते हैं अन्य मॉडलों का कार्यक्रम.<ref name=":4" />* रूपांतरण:<ref name=":20">{{Cite book|last1=Jiang|first1=Xiaotian|last2=Wang|first2=Quan|last3=Wang|first3=Bin|title=Proceedings of the 2019 Conference of the North |chapter=Adaptive Convolution for Multi-Relational Learning |date=June 2019 |chapter-url=https://www.aclweb.org/anthology/N19-1103 |publisher=Association for Computational Linguistics|pages=978–987|doi=10.18653/v1/N19-1103|s2cid=174800352}}</ref> ConvR अनुकूली दृढ़ नेटवर्क है जिसका उद्देश्य एम्बेडिंग और संबंधों के बीच सभी संभावित इंटरैक्शन का गहराई से प्रतिनिधित्व करना है।<ref name=":20" />इस क्रिया के लिए, ConvR, प्रत्येक संबंध के लिए संकेंद्रित फ़िल्टर की गणना करता है, और, जब आवश्यक हो, जटिल सुविधाओं को निकालने के लिए इन फ़िल्टरों को रुचि की इकाई पर लागू करता है।<ref name=":20" />ट्रिपल के स्कोर की गणना करने की प्रक्रिया ConvE के समान है।<ref name=":1" />* रूपांतरणKB:<ref name=":21">{{Cite book|last1=Nguyen|first1=Dai Quoc|last2=Nguyen|first2=Tu Dinh|last3=Nguyen|first3=Dat Quoc|last4=Phung|first4=Dinh|title=Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 2 (Short Papers) |chapter=A Novel Embedding Model for Knowledge Base Completion Based on Convolutional Neural Network |date=2018 |pages=327–333|doi=10.18653/v1/N18-2053|arxiv=1712.02121|s2cid=3882054}}</ref> ConvKB, किसी दिए गए ट्रिपल के स्कोर फ़ंक्शन की गणना करने के लिए <math>(h, r, t)</math>, यह इनपुट उत्पन्न करता है <chem>[h; \mathcal{r}; t]</chem>आयाम का <math>d \times 3</math> बिना दोबारा आकार दिए और इसे आकार के कनवल्शनल फिल्टर की श्रृंखला में भेज देता है <math>1 \times 3</math>.<ref name=":21" />यह परिणाम केवल न्यूरॉन के साथ सघन परत को पोषित करता है जो अंतिम स्कोर उत्पन्न करता है।<ref name=":21" />एकल अंतिम न्यूरॉन इस आर्किटेक्चर को बाइनरी क्लासिफायरियर के रूप में बनाता है जिसमें तथ्य उचित या अनुचित हो सकता है।<ref name=":1" />ConvE के साथ अंतर यह है कि एम्बेडिंग की आयामीता नहीं बदली जाती है।<ref name=":25" /> | ||

==== [[कैप्सूल तंत्रिका नेटवर्क|कैप्सूल तंट्रिपला नेटवर्क]] ==== | ==== [[कैप्सूल तंत्रिका नेटवर्क|कैप्सूल तंट्रिपला नेटवर्क]] ==== | ||

मॉडलों का यह परिवार अधिक स्थिर प्रतिनिधित्व बनाने के लिए कैप्सूल न्यूरल नेटवर्क का उपयोग करता है जो स्थानिक सूचना खोए बिना इनपुट में सुविधा को पहचानने में सक्षम है।<ref name=":1" />नेटवर्क संकेंद्रित परतों से बना है, लेकिन वे कैप्सूल में व्यवस्थित होते हैं, और कैप्सूल का समग्र परिणाम गतिशील प्रक्रिया रूटीन द्वारा तय किए गए उच्च-कैप्सूल को भेजा जाता है।<ref name=":1" />* कैप्स:<ref name=":23">{{cite arXiv|last1=Nguyen|first1=Dai Quoc|last2=Vu|first2=Thanh|last3=Nguyen|first3=Tu Dinh|last4=Nguyen|first4=Dat Quoc|last5=Phung|first5=Dinh|date=2019-03-06|title=ज्ञान ग्राफ़ पूर्णता और खोज वैयक्तिकरण के लिए एक कैप्सूल नेटवर्क-आधारित एंबेडिंग मॉडल|class=cs.CL|eprint=1808.04122}}</ref> कैप्सई किसी तथ्य को मॉडल करने के लिए कैप्सूल नेटवर्क लागू करता है <math>(h, r, t)</math>.<ref name=":23" />ConvKB | मॉडलों का यह परिवार अधिक स्थिर प्रतिनिधित्व बनाने के लिए कैप्सूल न्यूरल नेटवर्क का उपयोग करता है जो स्थानिक सूचना खोए बिना इनपुट में सुविधा को पहचानने में सक्षम है।<ref name=":1" />नेटवर्क संकेंद्रित परतों से बना है, लेकिन वे कैप्सूल में व्यवस्थित होते हैं, और कैप्सूल का समग्र परिणाम गतिशील प्रक्रिया रूटीन द्वारा तय किए गए उच्च-कैप्सूल को भेजा जाता है।<ref name=":1" />* कैप्स:<ref name=":23">{{cite arXiv|last1=Nguyen|first1=Dai Quoc|last2=Vu|first2=Thanh|last3=Nguyen|first3=Tu Dinh|last4=Nguyen|first4=Dat Quoc|last5=Phung|first5=Dinh|date=2019-03-06|title=ज्ञान ग्राफ़ पूर्णता और खोज वैयक्तिकरण के लिए एक कैप्सूल नेटवर्क-आधारित एंबेडिंग मॉडल|class=cs.CL|eprint=1808.04122}}</ref> कैप्सई किसी तथ्य को मॉडल करने के लिए कैप्सूल नेटवर्क लागू करता है <math>(h, r, t)</math>.<ref name=":23" />ConvKB के जैसे, मैट्रिक्स बनाने के लिए प्रत्येक ट्रिपल तत्व को संयोजित किया जाता है <chem>[h; \mathcal{r}; t]</chem>और इसका उपयोग कन्वेन्शनल फीचर्स को निकालने के लिए कन्वेन्शनल लेयर को फीड करने के लिए किया जाता है।<ref name=":1" /><ref name=":23" />फिर इन विशेषताओं को सतत सदिश बनाने के लिए कैप्सूल पर पुनर्निर्देशित किया जाता है, सदिश जितना लंबा होगा, तथ्य उतना ही अधिक सत्य होगा।<ref name=":23" /> | ||

==== [[आवर्तक तंत्रिका नेटवर्क|आवर्तक तंट्रिपला नेटवर्क]] ==== | ==== [[आवर्तक तंत्रिका नेटवर्क|आवर्तक तंट्रिपला नेटवर्क]] ==== | ||

मॉडलों का यह वर्ग आवर्ती तंट्रिपला नेटवर्क के उपयोग का लाभ उठाता है।<ref name=":1" />इस वास्तुकला का लाभ केवल विस्तृत एकल घटनाओं के बजाय तथ्यों के अनुक्रम को याद रखना है।<ref name=":24" />* आरएसएन:<ref name=":24">{{cite arXiv|last1=Guo|first1=Lingbing|last2=Sun|first2=Zequn|last3=Hu|first3=Wei|date=2019-05-13|title=ज्ञान ग्राफ़ में दीर्घकालिक संबंधपरक निर्भरता का दोहन करना सीखना|class=cs.AI|eprint=1905.04914}}</ref> एम्बेडिंग प्रक्रिया के दौरान सामान्यतः यह माना जाता है कि, समान एम्बेडिंग के समान संबंध होते हैं।<ref name=":24" />व्यवहार में, इस प्रकार की सूचना का लाभ नहीं उठाया जाता है, क्योंकि एम्बेडिंग की गणना तथ्यों के इतिहास के बजाय केवल मौजूदा तथ्य पर की जाती है।<ref name=":24" />आवर्तक स्किपिंग नेटवर्क (आरएसएन) रैंडम वॉक सैंपलिंग का उपयोग करके संबंधपरक पथ सीखने के लिए आवर्तक तंट्रिपला नेटवर्क का उपयोग करता है।<ref name=":1" /><ref name=":24" /> | मॉडलों का यह वर्ग आवर्ती तंट्रिपला नेटवर्क के उपयोग का लाभ उठाता है।<ref name=":1" />इस वास्तुकला का लाभ केवल विस्तृत एकल घटनाओं के बजाय तथ्यों के अनुक्रम को याद रखना है।<ref name=":24" />* आरएसएन:<ref name=":24">{{cite arXiv|last1=Guo|first1=Lingbing|last2=Sun|first2=Zequn|last3=Hu|first3=Wei|date=2019-05-13|title=ज्ञान ग्राफ़ में दीर्घकालिक संबंधपरक निर्भरता का दोहन करना सीखना|class=cs.AI|eprint=1905.04914}}</ref> एम्बेडिंग प्रक्रिया के दौरान सामान्यतः यह माना जाता है कि, समान एम्बेडिंग के समान संबंध होते हैं।<ref name=":24" />व्यवहार में, इस प्रकार की सूचना का लाभ नहीं उठाया जाता है, क्योंकि एम्बेडिंग की गणना तथ्यों के इतिहास के बजाय केवल मौजूदा तथ्य पर की जाती है।<ref name=":24" />आवर्तक स्किपिंग नेटवर्क (आरएसएन) रैंडम वॉक सैंपलिंग का उपयोग करके संबंधपरक पथ सीखने के लिए आवर्तक तंट्रिपला नेटवर्क का उपयोग करता है।<ref name=":1" /><ref name=":24" /> | ||

== मॉडल प्रदर्शन == | == मॉडल प्रदर्शन == | ||

नॉलेज ग्राफ़ एम्बेडिंग के लिए मशीन लर्निंग | नॉलेज ग्राफ़ एम्बेडिंग के लिए मशीन लर्निंग क्रिया जो मॉडलों की एम्बेडिंग यथार्थता का मूल्यांकन करने के लिए अधिक बार उपयोग किया जाता है वह लिंक भविष्यवाणी है।<ref name=":0" /><ref name=":2" /><ref name=":1" /><ref name=":27" /><ref name=":3" /><ref name=":4" />रॉसी एट अल.<ref name=":1" />मॉडलों का व्यापक बेंचमार्क तैयार किया, लेकिन अन्य सर्वेक्षण भी समान परिणाम देते हैं।<ref name=":2" /><ref name=":3" /><ref name=":4" /><ref name=":26" />[[बेंचमार्क (कंप्यूटिंग)]] में पांच डेटासेट FB15k सम्मिलित हैं,<ref name=":9" />एक 18,<ref name=":9" />FB15k-237,<ref name=":28">{{Cite book|last1=Toutanova|first1=Kristina|last2=Chen|first2=Danqi|title=Proceedings of the 3rd Workshop on Continuous Vector Space Models and their Compositionality |chapter=Observed versus latent features for knowledge base and text inference |date=July 2015 |chapter-url=https://www.aclweb.org/anthology/W15-4007 |publisher=Association for Computational Linguistics|pages=57–66|doi=10.18653/v1/W15-4007|s2cid=5378837|doi-access=free}}</ref> वन18र्रर्र,<ref name=":29"/>और YAGO3-10.<ref name=":30">{{Cite journal|last1=Mahdisoltani|first1=F.|last2=Biega|first2=J.|last3=Suchanek|first3=Fabian M.|date=2015|title=YAGO3: A Knowledge Base from Multilingual Wikipedias|url=https://www.semanticscholar.org/paper/YAGO3:-A-Knowledge-Base-from-Multilingual-Mahdisoltani-Biega/6c5b5adc3830ac45bf1d764603b1b71e5f729616|journal=CIDR|s2cid=6611164}}</ref> वर्तमान में, यह चर्चा हुई है कि ये डेटासेट वास्तविक संसार के अनुप्रयोगों से बहुत दूर हैं, और अन्य डेटासेट को मानक बेंचमार्क के रूप में एकीकृत किया जाना चाहिए।<ref>{{cite arXiv|last1=Hu|first1=Weihua|last2=Fey|first2=Matthias|last3=Zitnik|first3=Marinka|last4=Dong|first4=Yuxiao|last5=Ren|first5=Hongyu|last6=Liu|first6=Bowen|last7=Catasta|first7=Michele|last8=Leskovec|first8=Jure|date=2021-02-24|title=Open Graph Benchmark: Datasets for Machine Learning on Graphs|class=cs.LG|eprint=2005.00687}}</ref> | ||

{| class="wikitable" | {| class="wikitable" | ||

| Line 140: | Line 143: | ||

|} | |} | ||

{| class="wikitable mw-collapsible" | {| class="wikitable mw-collapsible" | ||

|+Hits@10, MR, और MRR के संदर्भ में रॉसी एट अल के अनुसार मेमोरी जटिलता और ज्ञान ग्राफ एम्बेडिंग मॉडल की लिंक भविष्यवाणी | |+Hits@10, MR, और MRR के संदर्भ में रॉसी एट अल के अनुसार मेमोरी जटिलता और ज्ञान ग्राफ एम्बेडिंग मॉडल की लिंक भविष्यवाणी यथार्थता का तालिका सारांश।<ref name=":1" /> प्रत्येक डेटासेट के लिए प्रत्येक मीट्रिक पर सर्वोत्तम परिणाम बोल्ड में हैं। | ||

!मॉडल नाम | !मॉडल नाम | ||

!मेमोरी जटिलता | !मेमोरी जटिलता | ||

Revision as of 20:50, 13 December 2023

प्रतिनिधित्व शिक्षण में, ज्ञान ग्राफ एम्बेडिंग (KGE), जिसे ज्ञान प्रतिनिधित्व शिक्षण (KRL), या बहु-संबंध शिक्षण भी कहा जाता है,[1] ज्ञान ग्राफ की एम्बेडिंग और संबंधों के अर्थपूर्ण अर्थ को संरक्षित करते हुए उनके निम्न-आयामी प्रतिनिधित्व को सीखने का एक मशीन सीखने का क्रिया है।[1][2][3] उनके एम्बेडिंग प्रतिनिधित्व का लाभ उठाते हुए, ज्ञान ग्राफ़ (केजी) का उपयोग लिंक भविष्यवाणी, ट्रिपल वर्गीकरण, इकाई मान्यता, क्लस्टर विश्लेषण और संबंध निष्कर्षण जैसे विभिन्न अनुप्रयोगों के लिए किया जा सकता है।[1][4]

परिभाषा

एक ज्ञान ग्राफ इकाई , संबंध , और तथ्य का एक संग्रह है।[5] एक तथ्य एक ट्रिपल है जो ट्रिपल के हेड और टेल के बीच एक लिंक को दर्शाता है। एक अन्य संकेतन जो प्रायः साहित्य में ट्रिपल (या तथ्य) का प्रतिनिधित्व करने के लिए उपयोग किया जाता है वह है । इस नोटेशन को संसाधन विवरण स्ट्रक्चर (आरडीएफ) कहा जाता है।[1][5] एक ज्ञान ग्राफ़ विशिष्ट डोमेन से संबंधित ज्ञान का प्रतिनिधित्व करता है; इस संरचित प्रतिनिधित्व का लाभ उठाते हुए, कुछ शोधन चरणों के बाद इससे नवीन ज्ञान का अनुमान लगाना संभव है।[6] यद्यपि, आजकल, लोगों को वास्तविक संसार के एप्लिकेशन में उनका उपयोग करने के लिए डेटा की विरलता और कम्प्यूटेशनल अक्षमता से निपटना पड़ता है।[3][7]

ज्ञान ग्राफ का एम्बेडिंग प्रत्येक इकाई और ज्ञान ग्राफ के संबंध, को किसी दिए गए आयाम , के सदिश में अनुवादित करता है, जिसे एम्बेडिंग आयाम कहा जाता है।[7] सामान्य स्थिति में, हमारे निकट इकाई और संबंध के लिए अलग-अलग एम्बेडिंग आयाम हो सकते हैं।[7] ज्ञान ग्राफ में सभी एम्बेडिंग और संबंधों के लिए एम्बेडिंग सदिश का संग्रह तब डाउनस्ट्रीम क्रियाओं के लिए उपयोग किया जा सकता है।

एक ज्ञान ग्राफ़ एम्बेडिंग को चार अलग-अलग गुणों की विशेषता है:[1]

- प्रतिनिधित्व समष्टि: निम्न-आयामी समष्टि जिसमें एम्बेडिंग और संबंधों का प्रतिनिधित्व किया जाता है।[1]

- स्कोरिंग फ़ंक्शन: ट्रिपल एम्बेडेड प्रतिनिधित्व की स्पष्टता का उपाय।[1]

- एन्कोडिंग मॉडल: वह पद्धति जिसमें एम्बेडिंग और संबंधों का एम्बेडेड प्रतिनिधित्व दूसरे के साथ अन्तःक्रिया करता है।[1]

- अतिरिक्त सूचना: ज्ञान ग्राफ से आने वाली कोई भी अतिरिक्त सूचना जो एम्बेडेड प्रतिनिधित्व को समृद्ध कर सकती है।[1] सामान्यतः, प्रत्येक अतिरिक्त सूचना के लिए तदर्थ स्कोरिंग फ़ंक्शन को सामान्य स्कोरिंग फ़ंक्शन में एकीकृत किया जाता है।[5][1][8]

एंबेडिंग प्रक्रिया

सभी अलग-अलग ज्ञान ग्राफ एम्बेडिंग मॉडल तथ्यों के अर्थपूर्ण अर्थ को जानने के लिए लगभग एक ही प्रक्रिया का पालन करते हैं।[7] सबसे पहले, ज्ञान ग्राफ के एम्बेडेड प्रतिनिधित्व को सीखने के लिए, एम्बेडिंग और संबंधों के एम्बेडिंग सदिश को यादृच्छिक मानों के लिए प्रारंभ किया जाता है।[7] फिर, प्रशिक्षण सेट से प्रारंभ करके स्टॉप स्थिति तक पहुंचने तक, एल्गोरिदम निरंतर एम्बेडिंग को अनुकूलित करता है।[7] सामान्यतः, स्टॉप की स्थिति प्रशिक्षण सेट पर ओवरफिटिंग द्वारा दी जाती है।[7] प्रत्येक पुनरावृत्ति के लिए, प्रशिक्षण सेट से आकार के एक बैच का नमूना लिया जाता है, और बैच के प्रत्येक ट्रिपल के लिए एक यादृच्छिक भ्रष्ट तथ्य का नमूना लिया जाता है—अर्थात, ट्रिपल जो ज्ञान ग्राफ में उचित तथ्य का प्रतिनिधित्व नहीं करता है।[7] ट्रिपल के भ्रष्टाचार में ट्रिपल के सिर या पूंछ (या दोनों) को किसी अन्य इकाई के साथ प्रतिस्थापित करना सम्मिलित है जो तथ्य को अनुचित बनाता है।[7] मूल ट्रिपल और दूषित ट्रिपल को प्रशिक्षण बैच में जोड़ा जाता है, और फिर स्कोरिंग फ़ंक्शन को अनुकूलित करते हुए एम्बेडिंग को अपडेट किया जाता है।[5][7] एल्गोरिदम के अंत में, सीखे गए एम्बेडिंग को ट्रिपल से अर्थपूर्ण अर्थ निकालना चाहिए और ज्ञान ग्राफ में अनदेखे उचित तथ्यों की उचित भविष्यवाणी करनी चाहिए।[5]

स्यूडोकोड

सामान्य एम्बेडिंग प्रक्रिया के लिए छद्मकोड निम्नलिखित है।[9][7]

algorithm Compute entity and relation embeddings is

input: The training set ,

entity set ,

relation set ,

embedding dimension

output: Entity and relation embeddings

initialization: the entities and relations embeddings (vectors) are randomly initialized

while stop condition do

// From the training set randomly sample a batch of size b

for each in do

// sample a corrupted fact of triple

end for

Update embeddings by minimizing the loss function

end while

प्रदर्शन संकेतक

इन सूचकांकों का उपयोग प्रायः किसी मॉडल की एम्बेडिंग गुणवत्ता को मापने के लिए किया जाता है। सूचकांकों की सरलता उन्हें बड़े पैमाने पर भी एम्बेडिंग एल्गोरिदम के प्रदर्शन का मूल्यांकन करने के लिए बहुत उपयुक्त बनाती है।[10] किसी मॉडल की सभी रैंक की गई भविष्यवाणियों के सेट के रूप में को देखते हुए, तीन अलग-अलग प्रदर्शन सूचकांकों को परिभाषित करना संभव है: Hits@K, MR, और MRR।[10]

Hits@K

Hits@K या संक्षेप में, H@K, प्रदर्शन सूचकांक है जो पहले शीर्ष के मॉडल भविष्यवाणियों में उचित भविष्यवाणी खोजने की संभावना को मापता है।[10] सामान्यतः इसका प्रयोग किया जाता है।[10] Hits@K दो दिए गए ट्रिपल के बीच संबंध की उचित भविष्यवाणी करने के लिए एम्बेडिंग मॉडल की यथार्थता को दर्शाता है।[10]

Hits@K

बड़े मानों का अर्थ स्पष्ट अनुमानित प्रदर्शन है।[10]

औसत रैंक (एमआर)

औसत रैंक सभी संभावित वस्तुओं के बीच मॉडल द्वारा अनुमानित वस्तुओं की औसत रैंकिंग स्थिति है।[10]

मान जितना छोटा होगा, मॉडल उतना ही स्पष्ट होगा।[10]

माध्य पारस्परिक रैंक (एमआरआर)

माध्य पारस्परिक रैंक उचित रूप से अनुमानित ट्रिपल की संख्या को मापता है।[10] यदि पहला अनुमानित ट्रिपल उचित है, तो 1 जोड़ा जाता है, यदि दूसरा उचित है तो का योग किया जाता है, और इसी प्रकार।[10]

औसत पारस्परिक रैंक का उपयोग सामान्यतः खोज एल्गोरिदम के प्रभाव को मापने के लिए किया जाता है।[10]

सूचकांक जितना बड़ा होगा, मॉडल उतना ही स्पष्ट होगा।[10]

अनुप्रयोग

मशीन लर्निंग क्रिया

ज्ञान ग्राफ पूर्णता (केजीसी) एम्बेडेड ज्ञान ग्राफ प्रतिनिधित्व से ज्ञान का अनुमान लगाने के लिए तकनीकों का संग्रह है।[11] विशेष रूप से, यह तकनीक लुप्त इकाई या संबंध का अनुमान लगाते हुए ट्रिपल को पूर्ण करती है।[11] संबंधित उप-क्रियाओं को लिंक या इकाई भविष्यवाणी (अर्थात, ट्रिपल की दूसरी इकाई और संबंध को देखते हुए एम्बेडिंग से इकाई का अनुमान लगाना), और संबंध भविष्यवाणी (अर्थात, दो इकाइयों को जोड़ने वाले सबसे प्रशंसनीय संबंध की भविष्यवाणी करना) नाम दिया गया है।[11]

ट्रिपल वर्गीकरण द्विआधारी वर्गीकरण समस्या है।[1] एक ट्रिपल को देखते हुए, प्रशिक्षित मॉडल एम्बेडिंग का उपयोग करके ट्रिपल की संभाव्यता का मूल्यांकन करता है ताकि यह निर्धारित किया जा सके कि ट्रिपल उचित है या अनुचित।[11] निर्णय मॉडल स्कोर फ़ंक्शन और दी गई सीमा के साथ किया जाता है।[11] क्लस्टरिंग अन्य एप्लिकेशन है जो 2डी स्पेस में समान सिमेंटिक इकाइयों के प्रतिनिधित्व को संक्षिप्त करने के लिए विरल ज्ञान ग्राफ के एम्बेडेड प्रतिनिधित्व का लाभ उठाता है।[4]

वास्तविक संसार के अनुप्रयोग

कई अनुप्रयोगों में ज्ञान ग्राफ एम्बेडिंग का उपयोग तीव्र से व्यापक हो रहा है। अनुशंसा प्रणाली की स्थिति में, ज्ञान ग्राफ एम्बेडिंग का उपयोग सामान्य सुदृढीकरण सीखने की सीमाओं को दूर कर सकता है।[12][13] इस प्रकार की अनुशंसा प्रणाली को प्रशिक्षित करने के लिए उपयोगकर्ताओं से भारी मात्रा में सूचना की आवश्यकता होती है; यद्यपि, ज्ञान ग्राफ़ तकनीकें आइटम सहसंबंध के पूर्व ज्ञान पर पहले से ही बनाए गए ग्राफ़ का उपयोग करके और उससे अनुशंसा का अनुमान लगाने के लिए एम्बेडिंग का उपयोग करके इस समस्या का समाधान कर सकती हैं।[12]औषधि पुनर्प्रयोजन पहले से ही अनुमोदित दवा का उपयोग है, लेकिन चिकित्सीय उद्देश्य के लिए उस उद्देश्य से भिन्न होता है जिसके लिए इसे प्रारंभ में डिज़ाइन किया गया था।[14] बड़े पैमाने पर साहित्य और बायोमेडिकल डेटाबेस की उपलब्धता का लाभ उठाकर निर्मित बायोमेडिकल ज्ञान ग्राफ का उपयोग करके पहले से मौजूद दवा और बीमारी के बीच नवीन संबंध का अनुमान लगाने के लिए लिंक भविष्यवाणी के क्रिया का उपयोग करना संभव है।[14]ज्ञान ग्राफ एम्बेडिंग का उपयोग सामाजिक राजनीति के क्षेत्र में भी किया जा सकता है।[4]

मॉडल

ट्रिपल (या तथ्यों) का संग्रह दिया गया ज्ञान ग्राफ एम्बेडिंग मॉडल, ज्ञान ग्राफ में मौजूद प्रत्येक इकाई और संबंध के लिए सतत सदिश प्रतिनिधित्व उत्पन्न करता है।[7] ट्रिपल का संगत एम्बेडिंग है और , कहाँ एम्बेडिंग के लिए एम्बेडिंग आयाम है, और रिश्तों के लिए.[7]किसी दिए गए मॉडल का स्कोर फ़ंक्शन द्वारा दर्शाया गया है और संबंध के एम्बेडिंग को देखते हुए हेड के एम्बेडिंग से टेल के एम्बेडिंग की दूरी को मापता है, या दूसरे शब्दों में, यह किसी दिए गए तथ्य के एम्बेडेड प्रतिनिधित्व की संभाव्यता को मापता है।[5]

रॉसी एट अल. एम्बेडिंग मॉडल की वर्गीकरण का प्रस्ताव करें और मॉडल के तीन मुख्य परिवारों की पहचान करें: टेंसर अपघटन मॉडल, ज्यामितीय मॉडल और गहन शिक्षण मॉडल।[5]

टेंसर अपघटन मॉडल

टेंसर अपघटन ज्ञान ग्राफ एम्बेडिंग मॉडल का परिवार है जो ज्ञान ग्राफ का प्रतिनिधित्व करने के लिए बहु-आयामी मैट्रिक्स का उपयोग करता है,[1][5][17]यह किसी विशेष डोमेन का पूर्ण रूप से वर्णन करने वाले ज्ञान ग्राफ के अंतराल के कारण आंशिक रूप से जानने योग्य है।[5]विशेष रूप से, ये मॉडल तीन-तरफा (3डी) टेन्सर का उपयोग करते हैं, जिसे बाद में निम्न-आयामी सदिश में विभाजित किया जाता है जो कि इकाइयां और संबंध एम्बेडिंग होते हैं।[5][17]तीसरे क्रम का टेंसर ज्ञान ग्राफ का प्रतिनिधित्व करने के लिए उपयुक्त पद्धति है क्योंकि यह केवल एम्बेडिंग के बीच संबंध के अस्तित्व या अनुपस्थिति को रिकॉर्ड करता है,[17]और इस कारण से यह सरल है, और नेटवर्क संरचना को प्राथमिकता से जानने की कोई आवश्यकता नहीं है,[15] एम्बेडिंग मॉडल के इस वर्ग को हल्का और प्रशिक्षित करना आसान बनाता है, भले ही वे उच्च-आयामी और डेटा की विरलता से पीड़ित हों।[5][17]

द्विरेखीय मॉडल

मॉडलों का यह परिवार संबंध के माध्यम से एम्बेडिंग के बीच संबंध को एम्बेड करने के लिए रैखिक समीकरण का उपयोग करता है।[1]विशेष रूप से, संबंधों का अंतर्निहित प्रतिनिधित्व द्विआयामी मैट्रिक्स है।[5]ये मॉडल, एम्बेडिंग प्रक्रिया के दौरान, एम्बेडेड प्रतिनिधित्व की गणना करने के लिए केवल एकल तथ्यों का उपयोग करते हैं और उसी इकाई या संबंध के अन्य संघों को अनदेखा करते हैं।[18] * DistMult[19]: चूंकि संबंध का एम्बेडिंग मैट्रिक्स विकर्ण मैट्रिक्स है,[5]स्कोरिंग फ़ंक्शन असममित तथ्यों को अलग नहीं कर सकता है।[5][18]

- जटिल[20]: चूंकि DistMult एम्बेडिंग संबंधों का प्रतिनिधित्व करने के लिए विकर्ण मैट्रिक्स का उपयोग करता है लेकिन जटिल सदिश स्पेस और हर्मिटियन उत्पाद में प्रतिनिधित्व जोड़ता है, यह सममित और असममित तथ्यों को अलग कर सकता है।[5][17] यह दृष्टिकोण समय और समष्टि लागत के संदर्भ में बड़े ज्ञान ग्राफ के लिए स्केलेबल है।[20]

- सादृश्य[21]: यह मॉडल आगमनात्मक तर्क को अनुकरण करने के लिए ज्ञान ग्राफ की अनुरूप संरचना को एम्बेड करने में एन्कोड करता है।[21][5][1]एक भिन्न उद्देश्य फ़ंक्शन का उपयोग करते हुए, ANALOGY में अच्छी सैद्धांतिक व्यापकता और कम्प्यूटेशनल स्केलेबिलिटी है।[21]यह सिद्ध है कि ANALOGY द्वारा निर्मित एम्बेडिंग DistMult, ComplEx, और HolE की एम्बेडिंग को पूर्ण रूप से पुनर्प्राप्त करती है।[21]* सरल[22]: यह मॉडल विहित बहुपद अपघटन (सीपी) का सुधार है, जिसमें संबंध के लिए एम्बेडिंग सदिश और प्रत्येक इकाई के लिए दो स्वतंत्र एम्बेडिंग सदिश सीखे जाते हैं, यह इस पर निर्भर करता है कि यह ज्ञान ग्राफ तथ्य में हेड या टेल है या नहीं।[22]SimpleE व्युत्क्रम संबंध का उपयोग करके दो इकाई एम्बेडिंग की स्वतंत्र सीखने की समस्या का समाधान करता है और सीपी स्कोर का औसत निकालता है और .[7][17]इस प्रकार, SimpleE एम्बेडिंग के बीच संबंध एकत्र करता है जबकि वे किसी तथ्य के अंदर विषय या वस्तु की भूमिका में दिखाई देते हैं, और यह असममित संबंधों को एम्बेड करने में सक्षम है।[5]

गैर-द्विरेखीय मॉडल

- छेद:[23] ज्ञान ग्राफ का एम्बेडेड प्रतिनिधित्व बनाने के लिए HolE परिपत्र सहसंबंध का उपयोग करता है,[23]जिसे मैट्रिक्स उत्पाद के संपीड़न के रूप में देखा जा सकता है, लेकिन असममित संबंध व्यक्त करने की क्षमताओं को बनाए रखते हुए अधिक कम्प्यूटेशनल रूप से कुशल और स्केलेबल है क्योंकि परिपत्र सहसंबंध क्रमविनिमेय नहीं है।[18]HolE होलोग्राफिक और जटिल एम्बेडिंग को जोड़ता है, यदि फूरियर रूपांतरण के साथ साथ उपयोग किया जाता है, तो इसे ComplEx के विशेष मामले के रूप में देखा जा सकता है।[1]* टकर:[24] टकर ज्ञान ग्राफ को टेंसर के रूप में देखता है जिसे सदिश के संग्रह में टकर अपघटन का उपयोग करके विघटित किया जा सकता है—अर्थात, एम्बेडिंग और संबंधों का एम्बेडिंग—साझा कोर के साथ।[24][5]कोर टेंसर का वजन एम्बेडिंग के साथ मिलकर सीखा जाता है और प्रविष्टियों के इंटरैक्शन के स्तर का प्रतिनिधित्व करता है।[25] प्रत्येक इकाई और संबंध का अपना एम्बेडिंग आयाम होता है, और कोर टेंसर का आकार परस्पर क्रिया करने वाली एम्बेडिंग और संबंधों के आकार से निर्धारित होता है।[5]किसी तथ्य के विषय और वस्तु के एम्बेडिंग को उसी प्रकार से संक्षेपित किया जाता है, जिससे टकर पूर्ण रूप से अभिव्यंजक हो जाता है, और अन्य एम्बेडिंग मॉडल जैसे कि RESCAL, DistMult, ComplEx और SimplE को टकर के विशेष फॉर्मूलेशन के रूप में व्यक्त किया जा सकता है।[24]* साथ:[26] एमईआई ब्लॉक टर्म टेंसर प्रारूप के साथ बहु-विभाजन एम्बेडिंग इंटरैक्शन तकनीक पेश करता है, जो सीपी अपघटन और टकर अपघटन का सामान्यीकरण है। यह एम्बेडिंग सदिश को कई विभाजनों में विभाजित करता है और ComplEx या SimpleE मॉडल जैसे निश्चित विशेष पैटर्न का उपयोग करने के बजाय डेटा से स्थानीय इंटरैक्शन पैटर्न सीखता है। यह एमईआई को इष्टतम दक्षता प्राप्त करने में सक्षम बनाता है - अभिव्यंजना व्यापार-बंद, न कि केवल पूर्ण रूप से अभिव्यंजक होना।[26]पिछले मॉडल जैसे TuckER, RESCAL, DistMult, ComplEx, और SimpleE MEI के उप-इष्टतम प्रतिबंधित विशेष मामले हैं।

- एमईआईएम:[27] एमईआईएम बहु-विभाजन एम्बेडिंग इंटरैक्शन के अलावा, एसेम्बल बूस्टिंग प्रभावों के लिए स्वतंत्र कोर टेंसर और अधिकतम-रैंक रिलेशनल मैपिंग के लिए सॉफ्ट ऑर्थोगोनलिटी को पेश करने के लिए ब्लॉक टर्म टेंसर प्रारूप से आगे जाता है। MEIM कई पिछले मॉडलों जैसे MEI और इसके सम्मिलित मॉडल, RotaE और QuatE को सामान्यीकृत करता है।[27]MEIN व्यवहार में अत्यधिक कुशल होते हुए भी अभिव्यंजना में सुधार करता है, जिससे इसे काफी छोटे मॉडल आकारों का उपयोग करके अच्छे परिणाम प्राप्त करने में मदद मिलती है।

ज्यामितीय मॉडल

मॉडलों के इस परिवार द्वारा परिभाषित ज्यामितीय समष्टि किसी तथ्य के सिर और पूंछ के बीच ज्यामितीय परिवर्तन के रूप में संबंध को कूटबद्ध करता है।[5]इस कारण से, पूंछ के एम्बेडिंग की गणना करने के लिए, परिवर्तन लागू करना आवश्यक है हेड एम्बेडिंग और दूरी फ़ंक्शन के लिए एम्बेडिंग की स्पष्टता को मापने या किसी तथ्य की विश्वसनीयता को स्कोर करने के लिए उपयोग किया जाता है।[5]

ज्यामितीय मॉडल टेंसर अपघटन मॉडल के समान हैं, लेकिन दोनों के बीच मुख्य अंतर यह है कि उन्हें परिवर्तन की प्रयोज्यता को संरक्षित करना होगा उस ज्यामितीय समष्टि में जिसमें इसे परिभाषित किया गया है।[5]

शुद्ध अनुवादात्मक मॉडल

मॉडलों का यह वर्ग Word2vec में पेश किए गए अनुवाद अपरिवर्तनीयता के विचार से प्रेरित है।[7]एक शुद्ध अनुवादात्मक मॉडल इस तथ्य पर निर्भर करता है कि इकाइयों के एम्बेडिंग सदिश ज्यामितीय समष्टि में उचित संबंधपरक अनुवाद लागू करने के बाद एक-दूसरे के करीब होते हैं जिसमें उन्हें परिभाषित किया जाता है।[18]दूसरे शब्दों में, तथ्य को देखते हुए, जब संबंध के एम्बेडिंग में हेड का एम्बेडिंग जोड़ा जाता है, तो अपेक्षित परिणाम टेल का एम्बेडिंग होना चाहिए।[5]एम्बेडिंग एम्बेडिंग की निकटता कुछ दूरी माप द्वारा दी जाती है और किसी तथ्य की विश्वसनीयता को निर्धारित करती है।[17]फ़ाइल:TransE.pdf|thumb|TransE एम्बेडिंग मॉडल। हेड का सदिश प्रतिनिधित्व (एम्बेडिंग) और संबंध का सदिश प्रतिनिधित्व टेल इकाई के सदिश प्रतिनिधित्व के बराबर होना चाहिए।