निर्णय वृक्ष सीखना

| Part of a series on |

| Machine learning and data mining |

|---|

|

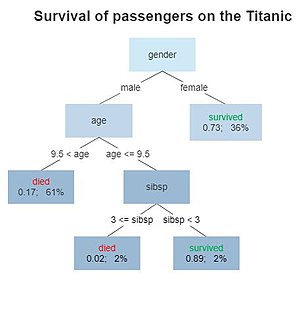

डिसीजन ट्री लर्निंग एक पर्यवेक्षित शिक्षण दृष्टिकोण है जिसका उपयोग सांख्यिकी, डेटा माइनिंग और मशीन लर्निंग में किया जाता है। इस औपचारिकता में, अवलोकनों के एक सेट के बारे में निष्कर्ष निकालने के लिए एक वर्गीकरण या प्रतिगमन निर्णय वृक्ष का उपयोग भविष्यवाणी मॉडल के रूप में किया जाता है।

ट्री मॉडल जहां लक्ष्य चर मूल्यों का असतत सेट ले सकता है उसे वर्गीकरण निर्णय वृक्ष कहा जाता है; इन वृक्ष संरचनाओं में, पर्ण्सन्धि वर्ग लेबल का प्रतिनिधित्व करता है और शाखाएँ उन विशेषताओं के तार्किक संयोजनों का प्रतिनिधित्व करती हैं जो उन वर्ग लेबलों की ओर ले जाती हैं। निर्णय वृक्ष जहां लक्ष्य चर निरंतर मान ले सकता है (आमतौर पर वास्तविक संख्या) को प्रतिगमन विश्लेषण निर्णय वृक्ष कहा जाता है।

निर्णय पेड़ सबसे लोकप्रिय मशीन लर्निंग एल्गोरिदम में से हैं, जो उनकी समझदारी और सरलता को देखते हैं।[1] निर्णय विश्लेषण में, एक निर्णय वृक्ष का उपयोग नेत्रहीन और स्पष्ट रूप से निर्णय लेने और निर्णय लेने का प्रतिनिधित्व करने के लिए किया जा सकता है। डेटा माइनिंग में, एक निर्णय वृक्ष डेटा का वर्णन करता है (लेकिन परिणामी वर्गीकरण वृक्ष निर्णय लेने के लिए एक इनपुट हो सकता है)।

सामान्य

डिसीजन ट्री लर्निंग डेटा माइनिंग में आमतौर पर इस्तेमाल की जाने वाली एक विधि है।[2] लक्ष्य एक मॉडल बनाना है जो कई इनपुट चर के आधार पर लक्ष्य चर के मूल्य की भविष्यवाणी करता है।

एक निर्णय वृक्ष उदाहरणों को वर्गीकृत करने के लिए एक सरल प्रतिनिधित्व है। इस खंड के लिए, मान लें कि सभी इनपुट फ़ीचर (मशीन लर्निंग) में परिमित असतत डोमेन हैं, और वर्गीकरण नामक एक एकल लक्ष्य विशेषता है। वर्गीकरण के डोमेन के प्रत्येक तत्व को एक वर्ग कहा जाता है। एक निर्णय वृक्ष या एक वर्गीकरण वृक्ष एक ऐसा वृक्ष है जिसमें प्रत्येक आंतरिक (गैर-पत्ती) नोड को एक इनपुट सुविधा के साथ लेबल किया जाता है। एक इनपुट फीचर के साथ लेबल किए गए नोड से आने वाले आर्क्स को टारगेट फीचर के प्रत्येक संभावित मान के साथ लेबल किया जाता है या आर्क एक अलग इनपुट फीचर पर एक अधीनस्थ निर्णय नोड की ओर जाता है। पेड़ के प्रत्येक पत्ते को एक वर्ग या वर्गों पर संभाव्यता वितरण के साथ लेबल किया जाता है, यह दर्शाता है कि डेटा सेट को पेड़ द्वारा या तो एक विशिष्ट वर्ग में वर्गीकृत किया गया है, या एक विशेष संभाव्यता वितरण में (जो, यदि निर्णय वृक्ष अच्छी तरह से है) -निर्मित, वर्गों के कुछ उपसमूहों की ओर तिरछा है)।

स्रोत सेट (गणित) को विभाजित करके एक पेड़ बनाया जाता है, जो पेड़ के रूट नोड को सबसेट में बनाता है - जो उत्तराधिकारी बच्चों का गठन करता है। विभाजन वर्गीकरण सुविधाओं के आधार पर विभाजन नियमों के एक सेट पर आधारित है।[3] यह प्रक्रिया प्रत्येक व्युत्पन्न उपसमुच्चय पर एक पुनरावर्ती तरीके से दोहराई जाती है जिसे पुनरावर्ती विभाजन कहा जाता है। पुनरावर्तन पूरा हो जाता है जब एक नोड पर सबसेट में लक्ष्य चर के सभी समान मान होते हैं, या जब विभाजन भविष्यवाणियों के लिए मूल्य नहीं जोड़ता है। डिसीजन ट्री (TDIDT) के टॉप-डाउन इंडक्शन की यह प्रक्रिया[4] एक लालची एल्गोरिथम का एक उदाहरण है, और यह डेटा से निर्णय वृक्ष सीखने के लिए अब तक की सबसे आम रणनीति है।[5] डाटा माइनिंग में, डिसीजन ट्री को डेटा के दिए गए सेट के विवरण, वर्गीकरण और सामान्यीकरण में सहायता के लिए गणितीय और कम्प्यूटेशनल तकनीकों के संयोजन के रूप में भी वर्णित किया जा सकता है।

डेटा फॉर्म के रिकॉर्ड में आता है:

आश्रित चर, , वह लक्ष्य चर है जिसे हम समझने, वर्गीकृत करने या सामान्य बनाने का प्रयास कर रहे हैं। सदिश सुविधाओं से बना है, आदि जो उस कार्य में प्रयुक्त होते हैं।

निर्णय वृक्ष प्रकार

डेटा माइनिंग में उपयोग किए जाने वाले निर्णय वृक्ष दो मुख्य प्रकार के होते हैं:

- वर्गीकरण ट्री विश्लेषण तब होता है जब अनुमानित परिणाम वह वर्ग (असतत) होता है जिससे डेटा संबंधित होता है।

- प्रतिगमन वृक्ष विश्लेषण तब होता है जब अनुमानित परिणाम को वास्तविक संख्या माना जा सकता है (उदाहरण के लिए घर की कीमत, या अस्पताल में रोगी की रहने की अवधि)।

शब्द वर्गीकरण और प्रतिगमन ट्री (CART) विश्लेषण एक छत्र शब्द है जिसका उपयोग उपरोक्त प्रक्रियाओं में से किसी एक को संदर्भित करने के लिए किया जाता है, जिसे पहले लियो ब्रिमन एट अल द्वारा प्रस्तुत किया गया था। 1984 में।[6] प्रतिगमन के लिए उपयोग किए जाने वाले पेड़ों और वर्गीकरण के लिए उपयोग किए जाने वाले पेड़ों में कुछ समानताएँ हैं - लेकिन कुछ अंतर भी हैं, जैसे कि विभाजित करने के लिए निर्धारित करने के लिए उपयोग की जाने वाली प्रक्रिया।[6]

कुछ तकनीकें, जिन्हें अक्सर पहनावा विधि कहा जाता है, एक से अधिक निर्णय वृक्ष का निर्माण करती हैं:

- 'ग्रेडिएंट बूस्टेड पेड़' पूर्व में गलत तरीके से तैयार किए गए प्रशिक्षण उदाहरणों पर जोर देने के लिए प्रत्येक नए उदाहरण को प्रशिक्षित करके एक पहनावा का निर्माण कर रहा है। एक विशिष्ट उदाहरण AdaBoost है। इनका उपयोग प्रतिगमन-प्रकार और वर्गीकरण-प्रकार की समस्याओं के लिए किया जा सकता है।[7][8]

- बूटस्ट्रैप एकत्रीकरण (या बैग्ड) डिसीजन ट्री, एक प्रारंभिक समेकन विधि, बार-बार बूटस्ट्रैपिंग (सांख्यिकी) द्वारा कई डिसीजन ट्री बनाता है, और आम सहमति की भविष्यवाणी के लिए ट्री को वोट करता है।[9]

- एक यादृच्छिक वन वर्गीकारक एक विशिष्ट प्रकार का बूटस्ट्रैप एकत्रीकरण है

- रोटेशन फ़ॉरेस्ट - जिसमें प्रत्येक निर्णय ट्री को पहले इनपुट सुविधाओं के एक यादृच्छिक सबसेट पर प्रमुख कंपोनेंट विश्लेषण (PCA) लागू करके प्रशिक्षित किया जाता है।[10]

निर्णय वृक्ष का एक विशेष मामला एक निर्णय सूची है,[11] जो एक तरफा निर्णय वृक्ष है, ताकि प्रत्येक आंतरिक नोड में एक बच्चे के रूप में ठीक 1 पत्ती का नोड और ठीक 1 आंतरिक नोड हो (सबसे नीचे के नोड को छोड़कर, जिसका एकमात्र बच्चा एकल पत्ती का नोड है)। जबकि कम अभिव्यंजक, निर्णय सूचियाँ उनकी अतिरिक्त विरलता के कारण सामान्य निर्णय वृक्षों की तुलना में समझने में यकीनन आसान हैं[citation needed], गैर-लालची सीखने के तरीकों की अनुमति दें[12] और monotonic बाधाओं को लगाया जाना है।[13] उल्लेखनीय निर्णय ट्री एल्गोरिदम में शामिल हैं:

- आईडी3 एल्गोरिथम (पुनरावृत्ति डाइकोटोमाइज़र 3)

- C4.5 एल्गोरिथ्म | C4.5 (ID3 का उत्तराधिकारी)

- प्रिडिक्टिव एनालिटिक्स#क्लासिफिकेशन और रिग्रेशन ट्री .28CART.29 (क्लासिफिकेशन एंड रिग्रेशन ट्री)[6]* ची-स्क्वायर स्वचालित इंटरैक्शन डिटेक्शन (CHAID)। वर्गीकरण ट्री की गणना करते समय बहु-स्तरीय विभाजन करता है।[14][15][16]

- बहुभिन्नरूपी अनुकूली प्रतिगमन स्प्लिन: संख्यात्मक डेटा को बेहतर ढंग से संभालने के लिए निर्णय पेड़ों का विस्तार करता है।

- सशर्त निष्कर्ष पेड़। सांख्यिकी-आधारित दृष्टिकोण जो गैर-पैरामीट्रिक परीक्षणों को विभाजन मानदंड के रूप में उपयोग करता है, ओवरफिटिंग से बचने के लिए कई परीक्षणों के लिए सही किया जाता है। इस दृष्टिकोण के परिणामस्वरूप निष्पक्ष भविष्यवक्ता चयन होता है और इसमें छंटाई की आवश्यकता नहीं होती है।[17][18]

ID3 और CART का आविष्कार लगभग एक ही समय (1970 और 1980 के बीच) स्वतंत्र रूप से किया गया था।[citation needed], फिर भी प्रशिक्षण टुपल्स से निर्णय वृक्ष सीखने के लिए एक समान दृष्टिकोण का पालन करें।

निर्णय ट्री के एक विशेष संस्करण की परिभाषा के लिए फ़ज़ी सेट सिद्धांत की अवधारणाओं का लाभ उठाने का भी प्रस्ताव किया गया है, जिसे फ़ज़ी डिसीज़न ट्री (FDT) के रूप में जाना जाता है।[19] इस प्रकार के फ़ज़ी वर्गीकरण में, आम तौर पर, एक इनपुट वेक्टर कई वर्गों से जुड़ा हुआ है, प्रत्येक एक अलग आत्मविश्वास मूल्य के साथ। एफडीटी के बूस्टेड एनसेंबल की हाल ही में जांच की गई है, और उन्होंने अन्य बहुत ही कुशल फ़ज़ी क्लासिफायर की तुलना में प्रदर्शन दिखाया है।[20]

मेट्रिक्स

निर्णय पेड़ों के निर्माण के लिए एल्गोरिदम आमतौर पर आइटम के सेट को विभाजित करने वाले प्रत्येक चरण पर एक चर चुनकर ऊपर से नीचे काम करते हैं।[5] सर्वश्रेष्ठ मापने के लिए अलग-अलग एल्गोरिदम अलग-अलग मेट्रिक्स का उपयोग करते हैं। ये आम तौर पर सबसेट के भीतर लक्ष्य चर की एकरूपता को मापते हैं। नीचे कुछ उदाहरण दिए गए हैं। ये मेट्रिक्स प्रत्येक उम्मीदवार सबसेट पर लागू होते हैं, और परिणामी मान संयुक्त होते हैं (उदाहरण के लिए, औसत) विभाजन की गुणवत्ता का एक माप प्रदान करने के लिए। अंतर्निहित मीट्रिक के आधार पर, निर्णय वृक्ष सीखने के लिए विभिन्न अनुमानी एल्गोरिदम का प्रदर्शन महत्वपूर्ण रूप से भिन्न हो सकता है।[21]

सकारात्मक शुद्धता का अनुमान

एक सरल और प्रभावी मीट्रिक का उपयोग उस डिग्री की पहचान करने के लिए किया जा सकता है जिस पर सच्ची सकारात्मकता वास्तविक नकारात्मकता से अधिक होती है (भ्रम मैट्रिक्स देखें)। यह मीट्रिक, सकारात्मक शुद्धता का अनुमान नीचे परिभाषित किया गया है:

इस समीकरण में, कुल झूठे धनात्मक (FP) को कुल सत्य धनात्मक (TP) से घटाया जाता है। परिणामी संख्या इस बात का अनुमान लगाती है कि सुविधा कितने सकारात्मक उदाहरणों को डेटा के भीतर सही ढंग से पहचान सकती है, उच्च संख्या के साथ जिसका अर्थ है कि सुविधा अधिक सकारात्मक नमूनों को सही ढंग से वर्गीकृत कर सकती है। नीचे एक उदाहरण दिया गया है कि किसी विशेष सुविधा का पूरा भ्रम मैट्रिक्स दिए जाने पर मीट्रिक का उपयोग कैसे किया जाता है:

फ़ीचर ए कन्फ्यूजन मैट्रिक्स

Predicted Class Actual Class

|

Cancer | Non-cancer |

|---|---|---|

| Cancer | 8 | 3 |

| Non-cancer | 2 | 5 |

यहाँ हम देख सकते हैं कि TP मान 8 होगा और FP मान 2 होगा (तालिका में रेखांकित संख्याएँ)। जब हम इन नंबरों को समीकरण में प्लग करते हैं तो हम अनुमान की गणना करने में सक्षम होते हैं: . इसका अर्थ है कि इस सुविधा पर अनुमान का उपयोग करने पर इसे 6 का स्कोर प्राप्त होगा।

हालांकि, यह ध्यान देने योग्य है कि यह संख्या केवल एक अनुमान है। उदाहरण के लिए, यदि दो विशेषताओं में दोनों का एफपी मान 2 था, जबकि एक विशेषता का उच्च टीपी मान था, तो उस विशेषता को दूसरे की तुलना में उच्च स्थान दिया जाएगा क्योंकि समीकरण का उपयोग करते समय परिणामी अनुमान अधिक मूल्य देगा। यदि कुछ विशेषताओं में अन्य की तुलना में अधिक सकारात्मक नमूने हैं, तो इससे मीट्रिक का उपयोग करते समय कुछ अशुद्धियाँ हो सकती हैं। इसका मुकाबला करने के लिए, संवेदनशीलता और विशिष्टता नामक एक अधिक शक्तिशाली मीट्रिक का उपयोग किया जा सकता है जो वास्तविक संवेदनशीलता और विशिष्टता (टीपीआर) देने के लिए भ्रम मैट्रिक्स से मूल्यों के अनुपात को ध्यान में रखता है। इन मीट्रिक के बीच का अंतर नीचे दिए गए उदाहरण में दिखाया गया है:

Feature A Confusion Matrix

|

फ़ीचर बी कन्फ्यूजन मैट्रिक्स

| ||||||||||||||||||

|

|

|

इस उदाहरण में, फीचर ए का अनुमान 6 और टीपीआर लगभग 0.73 था जबकि फीचर बी का अनुमान 4 और टीपीआर 0.75 था। इससे पता चलता है कि हालांकि कुछ फीचर के लिए सकारात्मक अनुमान अधिक हो सकता है, लेकिन उस फीचर के लिए अधिक सटीक टीपीआर मूल्य कम सकारात्मक अनुमान वाली अन्य सुविधाओं की तुलना में कम हो सकता है। डेटा और डिसीजन ट्री की स्थिति और ज्ञान के आधार पर, कोई अपनी समस्या के त्वरित और आसान समाधान के लिए सकारात्मक अनुमान का उपयोग करने का विकल्प चुन सकता है। दूसरी ओर, एक अधिक अनुभवी उपयोगकर्ता सुविधाओं को रैंक करने के लिए TPR मान का उपयोग करना पसंद करेगा क्योंकि यह डेटा के अनुपात और उन सभी नमूनों को ध्यान में रखता है जिन्हें सकारात्मक के रूप में वर्गीकृत किया जाना चाहिए था।

गिनी अशुद्धता

गिनी अशुद्धता, गिनी की विविधता सूचकांक,[22] या Diversity_index#Gini%E2%80%93Simpson_index|Gini-Simpson Index जैव विविधता अनुसंधान में, वर्गीकरण पेड़ों के लिए CART (वर्गीकरण और प्रतिगमन ट्री) एल्गोरिथ्म द्वारा उपयोग किया जाता है, Gini अशुद्धता (इतालवी गणितज्ञ Corrado Gini के नाम पर) एक उपाय है कि कैसे अक्सर सेट से यादृच्छिक रूप से चुने गए तत्व को गलत तरीके से लेबल किया जाएगा यदि इसे सबसेट में लेबल के वितरण के अनुसार यादृच्छिक रूप से लेबल किया गया हो। गिन्नी अशुद्धता की गणना संभाव्यता को जोड़कर की जा सकती है लेबल वाले किसी आइटम का संभाव्यता से गुणा चुना जा रहा है उस वस्तु को वर्गीकृत करने में गलती के कारण। यह अपने न्यूनतम (शून्य) तक पहुँच जाता है जब नोड के सभी मामले एक लक्ष्य श्रेणी में आते हैं।

गिन्नी अशुद्धता भी एक सूचना सिद्धांत उपाय है और विरूपण गुणांक के साथ सॉलिस एंट्रॉपी से मेल खाती है , जो भौतिक विज्ञान में आउट-ऑफ-संतुलन, गैर-व्यापक, विघटनकारी और क्वांटम सिस्टम में जानकारी की कमी से जुड़ा है। सीमा के लिए एक सामान्य बोल्ट्जमैन-गिब्स या शैनन एन्ट्रापी को पुनः प्राप्त करता है। इस अर्थ में, गिन्नी अशुद्धता और कुछ नहीं बल्कि निर्णय पेड़ों के लिए सामान्य एन्ट्रापी माप की भिन्नता है।

वस्तुओं के एक सेट के लिए गिन्नी अशुद्धता की गणना करना वर्ग, मान लीजिए , और जाने वर्ग के साथ लेबल किए गए आइटम का अंश हो सेट में।

सूचना प्राप्ति

ID3 एल्गोरिथ्म, C4.5 एल्गोरिथम | C4.5 और C5.0 ट्री-जेनरेशन एल्गोरिदम द्वारा उपयोग किया जाता है। सूचना लाभ सूचना एन्ट्रापी की अवधारणा और सूचना सिद्धांत से सूचना सामग्री पर आधारित है।

एंट्रॉपी को नीचे परिभाषित किया गया है

कहाँ पे अंश हैं जो 1 तक जोड़ते हैं और बच्चे के नोड में मौजूद प्रत्येक वर्ग के प्रतिशत का प्रतिनिधित्व करते हैं जो पेड़ में विभाजन के परिणामस्वरूप होता है। <रेफरी नाम = विटन 2011 102-103>Witten, Ian; Frank, Eibe; Hall, Mark (2011). डेटा माइनिंग. Burlington, MA: Morgan Kaufmann. pp. 102–103. ISBN 978-0-12-374856-0.</रेफरी>

के संभावित मूल्यों पर औसत ,

- जहां एंट्रॉपी का भारित योग दिया जाता है,

अर्थात्, अपेक्षित सूचना लाभ पारस्परिक सूचना है, जिसका अर्थ है कि औसतन T की एन्ट्रापी में कमी पारस्परिक सूचना है।

सूचना लाभ का उपयोग यह तय करने के लिए किया जाता है कि पेड़ के निर्माण में प्रत्येक चरण में किस सुविधा को विभाजित किया जाए। सरलता सर्वोत्तम है, इसलिए हम अपने पेड़ को छोटा रखना चाहते हैं। ऐसा करने के लिए, प्रत्येक चरण पर हमें उस विभाजन को चुनना चाहिए जिसके परिणामस्वरूप सबसे सुसंगत चाइल्ड नोड हो। स्थिरता के आमतौर पर इस्तेमाल किए जाने वाले माप को सूचना सिद्धांत कहा जाता है जिसे काटा्स में मापा जाता है। पेड़ के प्रत्येक नोड के लिए, सूचना मूल्य सूचना की अपेक्षित मात्रा का प्रतिनिधित्व करता है जो यह निर्दिष्ट करने के लिए आवश्यक होगा कि एक नया उदाहरण हाँ या नहीं में वर्गीकृत किया जाना चाहिए, यह देखते हुए कि उदाहरण उस नोड तक पहुंच गया है।Cite error: Invalid <ref> tag; invalid names, e.g. too many

चार विशेषताओं के साथ एक उदाहरण डेटा सेट पर विचार करें: आउटलुक (धूप, घटाटोप, बरसात), तापमान (गर्म, हल्का, ठंडा), आर्द्रता (उच्च, सामान्य), और हवादार (सच, गलत), बाइनरी (हाँ या नहीं) के साथ लक्ष्य चर, खेल और 14 डेटा बिंदु। इस डेटा पर एक निर्णय ट्री बनाने के लिए, हमें चार पेड़ों में से प्रत्येक के सूचना लाभ की तुलना करने की आवश्यकता है, प्रत्येक चार विशेषताओं में से एक पर विभाजित होता है। उच्चतम सूचना लाभ वाले विभाजन को पहले विभाजन के रूप में लिया जाएगा और यह प्रक्रिया तब तक जारी रहेगी जब तक कि सभी चिल्ड्रन नोड्स में सुसंगत डेटा न हो, या जब तक सूचना लाभ 0 न हो।

विंडी का उपयोग करके विभाजन की जानकारी प्राप्त करने के लिए, हमें पहले विभाजन से पहले डेटा में जानकारी की गणना करनी चाहिए। मूल डेटा में नौ हां और पांच ना शामिल थे।

विंडी सुविधा का उपयोग करके विभाजित करने से दो चिल्ड्रन नोड बनते हैं, एक ट्रू के विंडी मान के लिए और दूसरा फ़ॉल्स के विंडी मान के लिए। इस डेटा सेट में, छह डेटा बिंदु हैं, जिनमें से एक वास्तविक हवादार मूल्य है, जिनमें से तीन का एक प्ले है (जहां प्ले लक्ष्य चर है) हां का मान और तीन का प्ले मान नहीं है। फाल्स के हवादार मान वाले आठ शेष डेटा बिंदुओं में दो नहीं और छह हाँ हैं। विंडी = ट्रू नोड की जानकारी की गणना उपरोक्त एंट्रॉपी समीकरण का उपयोग करके की जाती है। चूँकि इस नोड में हाँ और ना की संख्या समान है, हमारे पास है

उस नोड के लिए जहां वाइंडी=फाल्स आठ डेटा बिंदु थे, छह हां और दो नहीं। इस प्रकार हमारे पास है

विभाजन की जानकारी प्राप्त करने के लिए, हम इन दो संख्याओं के भारित औसत को इस आधार पर लेते हैं कि कितने अवलोकन किस नोड में गिरे।

अब हम विंडी फीचर पर विभाजन द्वारा प्राप्त सूचना लाभ की गणना कर सकते हैं।

वृक्ष के निर्माण के लिए, प्रत्येक संभव प्रथम विभाजन के सूचना लाभ की गणना करने की आवश्यकता होगी। सबसे अच्छा पहला विभाजन वह है जो सबसे अधिक सूचना लाभ प्रदान करता है। पेड़ पूरा होने तक प्रत्येक अशुद्ध नोड के लिए यह प्रक्रिया दोहराई जाती है। यह उदाहरण Witten et al.Cite error: Invalid <ref> tag; invalid names, e.g. too many में प्रदर्शित होने वाले उदाहरण से लिया गया है।

सूचना लाभ को जैव विविधता अनुसंधान में Diversity_index#Shannon_index के रूप में भी जाना जाता है।

भिन्नता में कमी

कार्ट में पेश किया गया,[6]विचरण में कमी अक्सर ऐसे मामलों में नियोजित होती है जहां लक्ष्य चर निरंतर (रिग्रेशन ट्री) होता है, जिसका अर्थ है कि कई अन्य मेट्रिक्स के उपयोग के लिए पहले लागू होने से पहले विवेक की आवश्यकता होगी। एक नोड के विचरण में कमी N लक्ष्य चर के विचरण की कुल कमी के रूप में परिभाषित किया गया है Y इस नोड पर विभाजन के कारण:

कहाँ पे , , तथा प्रीस्प्लिट सैंपल इंडेक्स का सेट है, सैंपल इंडेक्स का सेट है जिसके लिए स्प्लिट टेस्ट ट्रू है, और सैंपल इंडेक्स का सेट है जिसके लिए स्प्लिट टेस्ट गलत है। उपरोक्त योगों में से प्रत्येक वास्तव में विचरण अनुमान हैं, हालांकि, सीधे अर्थ का उल्लेख किए बिना एक रूप में लिखा गया है।

अच्छाई का पैमाना

1984 में CART द्वारा उपयोग किया गया,[23] अच्छाई का माप एक ऐसा कार्य है जो समान आकार के बच्चों को बनाने की क्षमता के साथ शुद्ध बच्चों को बनाने के लिए एक उम्मीदवार विभाजन की क्षमता के संतुलन को अनुकूलित करना चाहता है। पेड़ पूरा होने तक प्रत्येक अशुद्ध नोड के लिए यह प्रक्रिया दोहराई जाती है। कार्यक्रम , कहाँ पे एक उम्मीदवार नोड पर विभाजित है , नीचे के रूप में परिभाषित किया गया है

कहाँ पे तथा नोड के बाएँ और दाएँ बच्चे हैं विभाजन का उपयोग करना , क्रमश; तथा में रिकॉर्ड के अनुपात हैं में तथा , क्रमश; तथा तथा वर्ग के अनुपात हैं में रिकॉर्ड तथा , क्रमश।

तीन विशेषताओं के साथ एक उदाहरण डेटा सेट पर विचार करें: बचत (निम्न, मध्यम, उच्च), संपत्ति (निम्न, मध्यम, उच्च), आय (संख्यात्मक मूल्य), और एक बाइनरी लक्ष्य चर क्रेडिट जोखिम (अच्छा, बुरा) और 8 डेटा बिंदु।[23]पूरा डेटा नीचे दी गई तालिका में प्रस्तुत किया गया है। निर्णय वृक्ष शुरू करने के लिए, हम अधिकतम मान की गणना करेंगे प्रत्येक सुविधा का उपयोग करके यह पता लगाने के लिए कि कौन रूट नोड को विभाजित करेगा। यह प्रक्रिया तब तक चलती रहेगी जब तक कि सभी बच्चे शुद्ध या सभी नहीं हो जाते मान एक निर्धारित सीमा से नीचे हैं।

| Customer | Savings | Assets | Income ($1000s) | Credit risk |

|---|---|---|---|---|

| 1 | Medium | High | 75 | Good |

| 2 | Low | Low | 50 | Bad |

| 3 | High | Medium | 25 | Bad |

| 4 | Medium | Medium | 50 | Good |

| 5 | Low | Medium | 100 | Good |

| 6 | High | High | 25 | Good |

| 7 | Low | Low | 25 | Bad |

| 8 | Medium | Medium | 75 | Good |

ढूँढ़ने के लिए सुविधा बचत के लिए, हमें प्रत्येक मान की मात्रा को नोट करना होगा। मूल डेटा में तीन लो, तीन मीडियम और दो हाई शामिल थे। निम्न में से किसी का क्रेडिट जोखिम अच्छा था जबकि मध्यम और उच्च में से 4 का क्रेडिट जोखिम अच्छा था। एक उम्मीदवार विभाजन मान लें जैसे कि कम बचत वाले रिकॉर्ड बाएं बच्चे में डाल दिए जाएंगे और अन्य सभी रिकॉर्ड दाएं बच्चे में डाल दिए जाएंगे।

पेड़ बनाने के लिए, रूट नोड के लिए सभी उम्मीदवारों के विभाजन की अच्छाई की गणना करने की आवश्यकता है। अधिकतम मूल्य वाला उम्मीदवार रूट नोड को विभाजित करेगा, और यह प्रक्रिया प्रत्येक अशुद्ध नोड के लिए तब तक जारी रहेगी जब तक कि पेड़ पूरा नहीं हो जाता।

सूचना लाभ जैसे अन्य मेट्रिक्स की तुलना में, अच्छाई का माप एक अधिक संतुलित पेड़ बनाने का प्रयास करेगा, जिससे निर्णय लेने में अधिक समय लगेगा। हालांकि, यह शुद्ध बच्चों को बनाने के लिए कुछ प्राथमिकता का त्याग करता है जिससे अतिरिक्त विभाजन हो सकते हैं जो अन्य मेट्रिक्स के साथ मौजूद नहीं हैं।

उपयोग करता है

लाभ

डेटा माइनिंग के अन्य तरीकों में, डिसीजन ट्री के कई फायदे हैं:

- समझने और व्याख्या करने में आसान। संक्षिप्त विवरण के बाद लोग निर्णय ट्री मॉडल को समझने में सक्षम होते हैं। पेड़ों को रेखांकन के रूप में भी प्रदर्शित किया जा सकता है जो गैर-विशेषज्ञों के लिए व्याख्या करना आसान है।[24]

- संख्यात्मक और श्रेणीबद्ध चर डेटा दोनों को संभालने में सक्षम।[24]अन्य तकनीकें आमतौर पर डेटासेट का विश्लेषण करने में विशिष्ट होती हैं जिनमें केवल एक प्रकार का चर होता है। (उदाहरण के लिए, संबंध नियमों का उपयोग केवल नाममात्र चर के साथ किया जा सकता है, जबकि तंत्रिका नेटवर्क का उपयोग केवल संख्यात्मक चर या श्रेणीबद्ध के साथ 0-1 मानों में परिवर्तित किया जा सकता है।) प्रारंभिक निर्णय पेड़ केवल श्रेणीबद्ध चर को संभालने में सक्षम थे, लेकिन हाल के संस्करण, जैसे C4.5 के रूप में, यह सीमा नहीं है।[2]* थोड़ा डेटा तैयार करने की आवश्यकता है। अन्य तकनीकों में अक्सर डेटा सामान्यीकरण की आवश्यकता होती है। चूंकि पेड़ गुणात्मक भविष्यवाणियों को संभाल सकते हैं, इसलिए डमी चर (सांख्यिकी) बनाने की कोई आवश्यकता नहीं है।[24]* एक सफेद बॉक्स (सॉफ्टवेयर इंजीनियरिंग) या ओपन-बॉक्स का उपयोग करता है[2]नमूना। यदि किसी मॉडल में दी गई स्थिति को देखा जा सकता है तो स्थिति की व्याख्या बूलियन लॉजिक द्वारा आसानी से समझाई जा सकती है। इसके विपरीत, एक ब्लैक बॉक्स मॉडल में, परिणामों के लिए स्पष्टीकरण को समझना आम तौर पर मुश्किल होता है, उदाहरण के लिए एक कृत्रिम तंत्रिका नेटवर्क के साथ।

- सांख्यिकीय परीक्षणों का उपयोग करके एक मॉडल को मान्य करना संभव है। इससे मॉडल की विश्वसनीयता का पता लगाना संभव हो जाता है।

- गैर-पैरामीट्रिक दृष्टिकोण जो प्रशिक्षण डेटा या भविष्यवाणी अवशेषों की कोई धारणा नहीं बनाता है; उदाहरण के लिए, कोई वितरणात्मक, स्वतंत्रता, या निरंतर भिन्नता धारणा नहीं

- बड़े डेटासेट के साथ अच्छा प्रदर्शन करता है। उचित समय में मानक कंप्यूटिंग संसाधनों का उपयोग करके बड़ी मात्रा में डेटा का विश्लेषण किया जा सकता है।

- अन्य दृष्टिकोणों की तुलना में मानव निर्णय लेने को अधिक बारीकी से प्रतिबिंबित करता है।[24]मानवीय निर्णयों/व्यवहार की मॉडलिंग करते समय यह उपयोगी हो सकता है।

- सह-रैखिकता के खिलाफ मजबूत, विशेष रूप से बढ़ावा देना।

- निर्मित सुविधा चयन में। अतिरिक्त अप्रासंगिक विशेषता का कम उपयोग किया जाएगा ताकि बाद के रन पर उन्हें हटाया जा सके। निर्णय वृक्ष में विशेषताओं का पदानुक्रम विशेषताओं के महत्व को दर्शाता है।[25] इसका मतलब है कि शीर्ष पर मौजूद सुविधाएं सबसे अधिक जानकारीपूर्ण हैं।[26]

- निर्णय वृक्ष किसी भी बूलियन प्रकार्य का अनुमान लगा सकते हैं उदा. एकमात्र।[27]

सीमाएं

- पेड़ बहुत गैर-मजबूत हो सकते हैं। प्रशिक्षण, परीक्षण और सत्यापन सेट में एक छोटे से बदलाव के परिणामस्वरूप पेड़ में बड़ा बदलाव हो सकता है और इसके परिणामस्वरूप अंतिम भविष्यवाणियां हो सकती हैं।[24]* एक इष्टतम निर्णय वृक्ष सीखने की समस्या को इष्टतमता के कई पहलुओं और यहां तक कि सरल अवधारणाओं के लिए भी एनपी-पूर्ण माना जाता है।[28][29] नतीजतन, व्यावहारिक निर्णय-ट्री लर्निंग एल्गोरिदम ह्यूरिस्टिक्स पर आधारित होते हैं जैसे कि लालची एल्गोरिथ्म जहां प्रत्येक नोड पर स्थानीय रूप से इष्टतम निर्णय किए जाते हैं। इस तरह के एल्गोरिदम विश्व स्तर पर इष्टतम निर्णय ट्री को वापस करने की गारंटी नहीं दे सकते। स्थानीय इष्टतमता के लालची प्रभाव को कम करने के लिए, दोहरी सूचना दूरी (DID) ट्री जैसी कुछ विधियों का प्रस्ताव किया गया था।[30]

- निर्णय-वृक्ष शिक्षार्थी अति-जटिल वृक्ष बना सकते हैं जो प्रशिक्षण डेटा से अच्छी तरह से सामान्यीकरण नहीं करते हैं। (इसे overfitting के रूप में जाना जाता है।[31]) इस समस्या से बचने के लिए प्रूनिंग (निर्णय वृक्ष) जैसे तंत्र आवश्यक हैं (कुछ एल्गोरिदम के अपवाद के साथ जैसे सशर्त अनुमान दृष्टिकोण, जिसमें छंटाई की आवश्यकता नहीं होती है)।[17][18]* वर्गीकरण तक नोड्स या परीक्षणों की संख्या द्वारा परिभाषित पेड़ की औसत गहराई को विभिन्न विभाजन मानदंडों के तहत न्यूनतम या छोटा होने की गारंटी नहीं है।[32] * विभिन्न स्तरों के साथ श्रेणीबद्ध चर सहित डेटा के लिए, निर्णय पेड़ों में सूचना लाभ अधिक स्तरों के साथ विशेषताओं के पक्ष में पक्षपाती है।[33] इस समस्या का मुकाबला करने के लिए, उच्चतम सूचना लाभ के साथ विशेषता को चुनने के बजाय, उन विशेषताओं के बीच उच्चतम सूचना लाभ अनुपात वाली विशेषता का चयन कर सकते हैं जिनकी सूचना लाभ औसत सूचना लाभ से अधिक है। [34] यह बहुत कम जानकारी प्राप्त करने वाली विशेषताओं को अनुचित लाभ न देते हुए, बड़ी संख्या में अलग-अलग मानों के साथ विशेषताओं पर विचार करने के विरुद्ध निर्णय वृक्ष को पक्षपाती बनाता है। वैकल्पिक रूप से, पक्षपाती भविष्यवक्ता चयन के मुद्दे को सशर्त अनुमान दृष्टिकोण से टाला जा सकता है,[17]एक दो चरणीय दृष्टिकोण,[35] या अनुकूली लीव-वन-आउट सुविधा चयन।[36]

कार्यान्वयन

कई डाटा माइनिंग सॉफ्टवेयर पैकेज एक या अधिक डिसीजन ट्री एल्गोरिदम के कार्यान्वयन प्रदान करते हैं।

उदाहरणों में शामिल

- सलफोर्ड सिस्टम्स कार्ट (जिसने मूल कार्ट लेखकों के मालिकाना कोड को लाइसेंस दिया था),[6]

- एसपीएसएस मॉडलर,

- रैपिडमाइनर,

- एसएएस (सॉफ्टवेयर) # अवयव,

- Matlab,

- R (प्रोग्रामिंग लैंग्वेज) (सांख्यिकीय कंप्यूटिंग के लिए एक ओपन-सोर्स सॉफ्टवेयर वातावरण, जिसमें कई CART कार्यान्वयन जैसे rpart, पार्टी और रैंडमफॉरेस्ट पैकेज शामिल हैं),

- वीका (मशीन लर्निंग) (एक स्वतंत्र और ओपन-सोर्स डेटा-माइनिंग सूट, जिसमें कई निर्णय ट्री एल्गोरिदम शामिल हैं),

- ऑरेंज (सॉफ्टवेयर),

- नीम,

- माइक्रोसॉफ्ट एसक्यूएल सर्वर [1], और

- scikit-सीखें (पाइथन (प्रोग्रामिंग लैंग्वेज) प्रोग्रामिंग लैंग्वेज के लिए एक फ्री और ओपन-सोर्स मशीन लर्निंग लाइब्रेरी)।

एक्सटेंशन

निर्णय रेखांकन

एक डिसीजन ट्री में, रूट नोड से लीफ नोड तक के सभी रास्ते संयुग्मन या AND के माध्यम से आगे बढ़ते हैं। एक निर्णय ग्राफ में, न्यूनतम संदेश लंबाई (एमएमएल) का उपयोग करके एक साथ दो और पथों में शामिल होने के लिए संयोजन (ओआरएस) का उपयोग करना संभव है।[37] पहले से अनकही नई विशेषताओं को गतिशील रूप से सीखने और ग्राफ़ के भीतर विभिन्न स्थानों पर उपयोग करने की अनुमति देने के लिए निर्णय ग्राफ़ को और बढ़ा दिया गया है।[38] अधिक सामान्य कोडिंग योजना के परिणामस्वरूप बेहतर भविष्य कहनेवाला सटीकता और लॉग-लॉस संभाव्य स्कोरिंग होती है।[citation needed] सामान्य तौर पर, निर्णय ग्राफ़ निर्णय पेड़ों की तुलना में कम पत्तियों वाले मॉडल का अनुमान लगाते हैं।

वैकल्पिक खोज विधियाँ

स्थानीय इष्टतम निर्णयों से बचने के लिए विकासवादी एल्गोरिदम का उपयोग किया गया है और निर्णय वृक्ष स्थान को थोड़ा प्राथमिकता पूर्वाग्रह के साथ खोजा गया है।[39][40] मार्कोव चेन मोंटे कार्लो का उपयोग करके एक पेड़ का नमूना लेना भी संभव है।[41] ट्री को बॉटम-अप फैशन में खोजा जा सकता है।[42] या वर्गीकरण तक परीक्षणों की अपेक्षित संख्या को कम करने के लिए समानांतर में कई पेड़ों का निर्माण किया जा सकता है।[32]

यह भी देखें

- निर्णय-वृक्ष छंटाई

- बाइनरी निर्णय आरेख

- छेद

- भविष्य कहनेवाला विश्लेषण # वर्गीकरण और प्रतिगमन पेड़ .28CART.29

- ID3 एल्गोरिथम

- C4.5 एल्गोरिथम

- निर्णय स्टंप, उदाहरण के लिए उपयोग किया जाता है। ऐडाबूस्टिंग

- निर्णय सूची

- वृद्धिशील निर्णय वृक्ष

- वैकल्पिक निर्णय वृक्ष

- संरचित डेटा विश्लेषण (सांख्यिकी)

- लॉजिस्टिक मॉडल ट्री

- पदानुक्रमित क्लस्टरिंग

संदर्भ

- ↑ Wu, Xindong; Kumar, Vipin; Ross Quinlan, J.; Ghosh, Joydeep; Yang, Qiang; Motoda, Hiroshi; McLachlan, Geoffrey J.; Ng, Angus; Liu, Bing; Yu, Philip S.; Zhou, Zhi-Hua (2008-01-01). "डेटा माइनिंग में शीर्ष 10 एल्गोरिदम". Knowledge and Information Systems. 14 (1): 1–37. doi:10.1007/s10115-007-0114-2. hdl:10983/15329. ISSN 0219-3116. S2CID 2367747.

- ↑ 2.0 2.1 2.2 Rokach, Lior; Maimon, O. (2014). निर्णय वृक्षों के साथ डाटा माइनिंग: सिद्धांत और अनुप्रयोग, दूसरा संस्करण. World Scientific Pub Co Inc. doi:10.1142/9097. ISBN 978-9814590075. S2CID 44697571.

- ↑ Shalev-Shwartz, Shai; Ben-David, Shai (2014). "18. Decision Trees". मशीन लर्निंग को समझना. Cambridge University Press.

- ↑ Quinlan, J. R. (1986). "निर्णय पेड़ों की प्रेरण" (PDF). Machine Learning. 1: 81–106. doi:10.1007/BF00116251. S2CID 189902138.

- ↑ 5.0 5.1 Rokach, L.; Maimon, O. (2005). "टॉप-डाउन इंडक्शन ऑफ डिसीजन ट्री क्लासिफायर-ए सर्वे". IEEE Transactions on Systems, Man, and Cybernetics - Part C: Applications and Reviews. 35 (4): 476–487. CiteSeerX 10.1.1.458.7031. doi:10.1109/TSMCC.2004.843247. S2CID 14808716.

- ↑ 6.0 6.1 6.2 6.3 6.4 Breiman, Leo; Friedman, J. H.; Olshen, R. A.; Stone, C. J. (1984). वर्गीकरण और प्रतिगमन पेड़. Monterey, CA: Wadsworth & Brooks/Cole Advanced Books & Software. ISBN 978-0-412-04841-8.

- ↑ Friedman, J. H. (1999). Stochastic gradient boosting Archived 2018-11-28 at the Wayback Machine. Stanford University.

- ↑ Hastie, T., Tibshirani, R., Friedman, J. H. (2001). The elements of statistical learning : Data mining, inference, and prediction. New York: Springer Verlag.

- ↑ Breiman, L. (1996). "बैगिंग प्रिडिक्टर्स". Machine Learning. 24 (2): 123–140. doi:10.1007/BF00058655.

- ↑ Rodriguez, J. J.; Kuncheva, L. I.; Alonso, C. J. (2006). "रोटेशन वन: एक नया वर्गीकारक पहनावा विधि". IEEE Transactions on Pattern Analysis and Machine Intelligence. 28 (10): 1619–1630. CiteSeerX 10.1.1.156.8277. doi:10.1109/TPAMI.2006.211. PMID 16986543. S2CID 6847493.

- ↑ Rivest, Ron (Nov 1987). "सीखना निर्णय सूची" (PDF). Machine Learning. 3 (2): 229–246. doi:10.1023/A:1022607331053. S2CID 30625841.

- ↑ Letham, Ben; Rudin, Cynthia; McCormick, Tyler; Madigan, David (2015). "नियमों और बायेसियन विश्लेषण का उपयोग करने वाले व्याख्यात्मक वर्गीकरणकर्ता: एक बेहतर स्ट्रोक भविष्यवाणी मॉडल का निर्माण". Annals of Applied Statistics. 9 (3): 1350–1371. arXiv:1511.01644. doi:10.1214/15-AOAS848. S2CID 17699665.

- ↑ Wang, Fulton; Rudin, Cynthia (2015). "गिरती नियम सूची" (PDF). Journal of Machine Learning Research. 38. Archived from the original (PDF) on 2016-01-28. Retrieved 2016-01-22.

- ↑ Kass, G. V. (1980). "बड़ी मात्रा में स्पष्ट डेटा की जांच के लिए एक खोजपूर्ण तकनीक". Applied Statistics. 29 (2): 119–127. doi:10.2307/2986296. JSTOR 2986296.

- ↑ Biggs, David; De Ville, Barry; Suen, Ed (1991). "वर्गीकरण और निर्णय वृक्षों के लिए बहुपथीय विभाजनों को चुनने की एक विधि". Journal of Applied Statistics. 18 (1): 49–62. doi:10.1080/02664769100000005. ISSN 0266-4763.

- ↑ Ritschard, G. (2013), "CHAID and Earlier Supervised Tree Methods", in J.J. McArdle and G. Ritschard (eds), Contemporary Issues in Exploratory Data Mining in the Behavioral Sciences, Quantitative Methodology Series, New York: Routledge, pages 48-74. Preprint

- ↑ 17.0 17.1 17.2 Hothorn, T.; Hornik, K.; Zeileis, A. (2006). "निष्पक्ष पुनरावर्ती विभाजन: एक सशर्त निष्कर्ष ढांचा". Journal of Computational and Graphical Statistics. 15 (3): 651–674. CiteSeerX 10.1.1.527.2935. doi:10.1198/106186006X133933. JSTOR 27594202. S2CID 6074128.

- ↑ 18.0 18.1 Strobl, C.; Malley, J.; Tutz, G. (2009). "पुनरावर्ती विभाजन का एक परिचय: औचित्य, अनुप्रयोग और वर्गीकरण और प्रतिगमन पेड़, बैगिंग और यादृच्छिक वन के लक्षण". Psychological Methods. 14 (4): 323–348. doi:10.1037/a0016973. PMC 2927982. PMID 19968396.

- ↑ Janikow, C. Z. (1998). "फजी डिसीजन ट्री: इश्यूज एंड मेथड्स". IEEE Transactions on Systems, Man and Cybernetics, Part B (Cybernetics). 28 (1): 1–14. doi:10.1109/3477.658573. PMID 18255917.

- ↑ Barsacchi, M.; Bechini, A.; Marcelloni, F. (2020). "An analysis of boosted ensembles of binary fuzzy decision trees". Expert Systems with Applications. 154: 113436. doi:10.1016/j.eswa.2020.113436. S2CID 216369273.

- ↑ Najmann, Oliver (1992). उदाहरणों से प्रतीकात्मक ज्ञान प्राप्त करने की तकनीक और अनुमान। (Thesis). Doctoral thesis.

- ↑ "बढ़ते निर्णय पेड़". MathWorks. MathWorks.

- ↑ 23.0 23.1 Larose, Daniel T.; Larose, Chantal D. (2014). डेटा में ज्ञान की खोज: डेटा माइनिंग का परिचय. Hoboken, NJ: John Wiley & Sons, Inc. ISBN 9781118874059.

- ↑ 24.0 24.1 24.2 24.3 24.4 Gareth, James; Witten, Daniela; Hastie, Trevor; Tibshirani, Robert (2015). सांख्यिकीय सीखने का एक परिचय. New York: Springer. pp. 315. ISBN 978-1-4614-7137-0.

- ↑ Provost, Foster, 1964- (2013). व्यवसाय के लिए डेटा विज्ञान: [डेटा खनन और डेटा-विश्लेषणात्मक सोच के बारे में आपको क्या जानने की आवश्यकता है]. Fawcett, Tom. (1st ed.). Sebastopol, Calif.: O'Reilly. ISBN 978-1-4493-6132-7. OCLC 844460899.

{{cite book}}: CS1 maint: multiple names: authors list (link) - ↑ Piryonesi S. Madeh; El-Diraby Tamer E. (2020-06-01). "इंफ्रास्ट्रक्चर एसेट मैनेजमेंट में डेटा एनालिटिक्स की भूमिका: डेटा आकार और गुणवत्ता की समस्याओं पर काबू पाना". Journal of Transportation Engineering, Part B: Pavements. 146 (2): 04020022. doi:10.1061/JPEODX.0000175. S2CID 216485629.

- ↑ Mehtaa, Dinesh; Raghavan, Vijay (2002). "बूलियन कार्यों का निर्णय वृक्ष सन्निकटन". Theoretical Computer Science. 270 (1–2): 609–623. doi:10.1016/S0304-3975(01)00011-1.

- ↑ Hyafil, Laurent; Rivest, RL (1976). "इष्टतम बाइनरी डिसीजन ट्री का निर्माण एनपी-पूर्ण है". Information Processing Letters. 5 (1): 15–17. doi:10.1016/0020-0190(76)90095-8.

- ↑ Murthy S. (1998). "Automatic construction of decision trees from data: A multidisciplinary survey". Data Mining and Knowledge Discovery

- ↑ Ben-Gal I. Dana A., Shkolnik N. and Singer (2014). "दोहरी सूचना दूरी विधि द्वारा निर्णय वृक्षों का कुशल निर्माण" (PDF). Quality Technology & Quantitative Management. 11 (1): 133–147. doi:10.1080/16843703.2014.11673330. S2CID 7025979.

- ↑ डाटा माइनिंग के सिद्धांत. 2007. doi:10.1007/978-1-84628-766-4. ISBN 978-1-84628-765-7.

- ↑ 32.0 32.1 Ben-Gal I. and Trister C. (2015). "परीक्षणों की लगातार गैर-बढ़ती अपेक्षित संख्या के साथ निर्णय वृक्षों का समानांतर निर्माण" (PDF). Applied Stochastic Models in Business and Industry, Vol. 31(1) 64-78.

- ↑ Deng, H.; Runger, G.; Tuv, E. (2011). बहु-मूल्यवान विशेषताओं और समाधानों के लिए महत्व के पूर्वाग्रह उपाय. Proceedings of the 21st International Conference on Artificial Neural Networks (ICANN). pp. 293–300.

- ↑ Quinlan, J. Ross (1986). "निर्णय वृक्षों का प्रेरण". Machine Learning. 1 (1): 81–106. doi:10.1007/BF00116251.

- ↑ Brandmaier, Andreas M.; Oertzen, Timo von; McArdle, John J.; Lindenberger, Ulman (2012). "संरचनात्मक समीकरण मॉडल पेड़।". Psychological Methods. 18 (1): 71–86. doi:10.1037/a0030001. hdl:11858/00-001M-0000-0024-EA33-9. PMC 4386908. PMID 22984789.

- ↑ Painsky, Amichai; Rosset, Saharon (2017). "ट्री-आधारित विधियों में क्रॉस-वैलिडेटेड वेरिएबल चयन, पूर्वानुमानित प्रदर्शन में सुधार करता है". IEEE Transactions on Pattern Analysis and Machine Intelligence. 39 (11): 2142–2153. arXiv:1512.03444. doi:10.1109/TPAMI.2016.2636831. PMID 28114007. S2CID 5381516.

- ↑ "साइटसीरएक्स".

- ↑ Tan & Dowe (2003)

- ↑ Papagelis, A.; Kalles, D. (2001). "Breeding Decision Trees Using Evolutionary Techniques" (PDF). मशीन लर्निंग पर अठारहवें अंतर्राष्ट्रीय सम्मेलन की कार्यवाही, 28 जून-जुलाई 1, 2001. pp. 393–400.

- ↑ Barros, Rodrigo C.; Basgalupp, M. P.; Carvalho, A. C. P. L. F.; Freitas, Alex A. (2012). "निर्णय-वृक्ष प्रेरण के लिए विकासवादी एल्गोरिदम का सर्वेक्षण". IEEE Transactions on Systems, Man and Cybernetics. Part C: Applications and Reviews. 42 (3): 291–312. CiteSeerX 10.1.1.308.9068. doi:10.1109/TSMCC.2011.2157494. S2CID 365692.

- ↑ Chipman, Hugh A.; George, Edward I.; McCulloch, Robert E. (1998). "बायेसियन कार्ट मॉडल खोज". Journal of the American Statistical Association. 93 (443): 935–948. CiteSeerX 10.1.1.211.5573. doi:10.1080/01621459.1998.10473750.

- ↑ Barros, R. C.; Cerri, R.; Jaskowiak, P. A.; Carvalho, A. C. P. L. F. (2011). "A bottom-up oblique decision tree induction algorithm". इंटेलिजेंट सिस्टम डिजाइन और एप्लीकेशन पर 11वें अंतर्राष्ट्रीय सम्मेलन की कार्यवाही (आईएसडीए 2011). pp. 450–456. doi:10.1109/ISDA.2011.6121697. ISBN 978-1-4577-1676-8. S2CID 15574923.

अग्रिम पठन

- James, Gareth; Witten, Daniela; Hastie, Trevor; Tibshirani, Robert (2017). "Tree-Based Methods" (PDF). An Introduction to Statistical Learning: with Applications in R. New York: Springer. pp. 303–336. ISBN 978-1-4614-7137-0.

इस पेज में लापता आंतरिक लिंक की सूची

- आंकड़े

- भविष्य कहनेवाला मॉडल

- निर्णय लेना

- प्रत्यावर्तन

- लालची एल्गोरिदम

- व्यापक शब्द

- वर्गीकरण वृक्ष

- बहुभिन्नरूपी अनुकूली रिग्रेशन स्प्लाइन

- असमंजस का जाल

- जानकारी सामग्री

- आपसी जानकारी

- झगड़ा

- श्रेणीगत चर

- फीचर चयन

- बूलियन समारोह

- एन पी-सम्पूर्ण

- छंटाई (निर्णय पेड़)

- आर (प्रोग्रामिंग भाषा)

- वेका (मशीन लर्निंग)

- पायथन (प्रोग्रामिंग भाषा)

- नारंगी (सॉफ्टवेयर)

- द्विआधारी निर्णय आरेख

बाहरी संबंध

- Templates that generate short descriptions

- Templates Translated in Hindi

- Articles with unsourced statements from December 2019

- Articles with unsourced statements from August 2014

- Articles with unsourced statements from January 2012

- निर्णय वृक्ष

- वर्गीकरण एल्गोरिदम

- Machine Translated Page

- Created On 14/12/2022